Продолжение поста «Обычный день в токийском метро»

Собственно, попробую подробно описать, как вам самостоятельно создать такое видео и попробую познакомить с несколькими тонкостями процесса.

Идея в условиях ограничений

Начнем с главного, а именно идеи вашего видео. Здесь очень важно понимать, что генеративные нейронки довольно ограничены в контексте продолжительности ваших видео. Поэтому вам нужно либо уметь компоновать разные кадры для вашей истории (используя перебивки, например, фокус на деталях одежды и т.д.), либо использовать на пост-монтаже звуковые переходы, либо ваша идея должна предполагать вариант спокойной смены кадров (в случае как у меня, это скорее вирусный ролик, где всю концепцию объединяет поезд с разными существами, связанных с японской мифологией или искусством).

В сухом остатке, ваша идея должна быть выполнима и адаптивна с учетом пока что несовершенных инструментов создания контента. То есть если вы захотели сгенерировать кота, который пашет на заводе, будьте готовы, что у него лапки, и например генеративный инструмент может не всегда адекватно воспринимать ваше пожелание.

Создание контента

Создание кадров

Мой процесс построен так:

Придумываю образ/концепт -> обращаюсь к GPT за помощью -> создаю картинку в Midjourney -> дорабатываю идею для анимации кадра в GPT -> иду анимировать в HailuoAi.

Зачем тут GPT? Для экономии времени. Вы создаете диалог, в котором прописываете следующую инструкцию:

Напиши 10 промтов на английском для Midjourney. Рядом с каждым промтом краткое описание на русском. Каждый промт содержит описание цветовой гаммы и света на кадре. Все промты должны быть нацелены на создание кинематографичного кадра (начинаются примерно с "cinema shot of..."). Концепция следующая: монстры-екаи в токийском метро. Разрешение 9:16 (укажи --ar 9:16) Каждый промт должен быть самодостаточным и поддерживать единую общую цветовую гамму концепции. В каждом промте должно быть уникальное существо.

Каждый может доработать по вкусу (разрешение кадра, концепция, кол-во промтов), но суть ясна. Далее в рамках этого диалога с GPT и работы с Midjourney мы отбираем контент, докидываем свои решения в стиле "О, а давай еще промт про девочку красивую в маске лисы, таинственно идущую в другой вагон". Также, учитывая предыдущий контент GPT поймет ваш запрос и выдаст вам примерный необходимый промт для Midjourney.

Часть промтов надо будет редактировать вручную, но это гораздо проще, чем прописывать каждый с самого начала или втухать, если идеи идут сложно.

Анимация кадров

Итак, вы отобрали кадры, теперь пора их оживлять. На помощь снова приходит GPT. Но уже с довольно сложным промтом (его надо скопировать и вставить в GPT):

Scene: The video starts with the camera zooming out from a close-up of the robotic cat's large eyes, revealing its entire body. The cat then moves slightly, its mechanical head turning to look down at its own body as if it's becoming aware of itself for the first time. It examines its paws, curiously tilting its head. The scene emphasizes the cat’s intricate robotic details, such as gears and the reflective surfaces.

Lighting: Soft, warm lighting fills the scene, highlighting the cat's golden metallic accents and giving a friendly, almost whimsical feel. The light glimmers off the polished surfaces of the cat’s mechanical components, making it seem lively.

Angle: The camera begins with a tight focus on the eyes, then pulls back smoothly, revealing the whole robot cat as it moves. As the cat inspects itself, the camera gently follows its gaze and movements, adding to the feeling of curiosity.

Color Correction: Golden and warm shades dominate the scene, with muted browns and metallic colors giving a steampunk feel. The reflective eyes have a glowing amber quality, adding warmth to the scene.

Action: The robotic cat lifts one paw, turns its head slightly, and looks at different parts of its body with apparent curiosity. The scene captures this as an exploration, showcasing both the robot's design and its almost childlike curiosity.

Camera Movement: The camera starts close on the eyes, then smoothly zooms out, maintaining a soft focus until the entire cat is visible. Once the camera has pulled back, it follows the cat’s slight movements as it explores itself, enhancing the sense of discovery.

Вот структура промта. На ее основе на китайском распиши промт для картинки, что я пришлю. Учитывай, что генеративные ИИ для видео не помнят предыдущий контекст и детали, чтобы сцены выглядели логичными и последовательными необходимо добавлять детали в каждом промте, а также делать их самодостаточными. Данный промт это структура для всех последующих промтов для генеративной нейросети по созданию видео или анимированию картинок. Каждый раз, когда я присылаю картинку, старайся описывать по такой структуре результат промта на основе моих вводных данных, если только не сказано иного. Добавляй к каждому промту краткое описание на русском в самом конце, чтобы я мог понять о чем речь.

Теперь, после того, как вы создали отдельный диалог и выгрузили туда данный промт - вы загружаете в диалог картинку со своим кадром и просите кратко что хотите, например "Персонаж стоит, смотрит в кадр, а затем начинает убегать прочь, отдаляясь от камеры". GPT преобразует это в сложный промт по структуре на китайском языке.

ВАЖНО: иногда, для простых действий этот сложный промт не подойдет, в этом случае я прошу GPT сильно упростить промт, но чтобы сохранился мой запрос анимации кадра. И тогда получаю короткий, но понятный промт.

Почему китайский? Изначально генеративный ИИ Hailuo имеет китайские корни, и под капотом натренирована чаще на запросах на этом языке. Поэтому можно пробовать английский и даже русский, но череда экспериментов показала, что в сложных инструкциях, китайский лучше.

Нюансы работы с генеративными ИИ

В начале поста я рассказывал про важность адаптивности, с чем это связано? Объясню на примере. Вот в моей голове в моем видео, ворон-тенгу, должен был превращаться в множество ворон, разлетающихся в разные стороны, итак, что у меня вышло после нескольких попыток:

В общем, ожидание не получилось воплотить в реальность, а учитывая, что каждую генерацию надо ждать от 5 до 10 минут, то была идея попробовать другие варианты, которые могли бы выглядеть более достойно. Для этого я поработал с GPT, спросил у модели, какие варианты он считает могут быть еще, подумал сам, сгенерировал простые и сложные промты и стал пробовать:

Вот оно, я понял, что бег выглядит более зрелищно и интересно, особенно в концепции вертикальных видео для соцсетей. Что делал далее, понял, что бег в этом ключе меня не устраивает, в рамках сложного промта и попробовал сделать его проще, в итоге получил это:

То есть важно помнить, что кроме изменений промта, есть еще фактор рандома, и ваш идеальный кадр может быть не сразу а спустя 3-4 генерации. В теории можно пробовать и хоть 10 генераций, но если честно обычно я рекомендую подумать еще или адаптировать промт/саму идею, т.к. если задачи, которые крайне сложно реализовать. Повторюсь, генеративные ИИ пока еще не идеально понимают запросы.

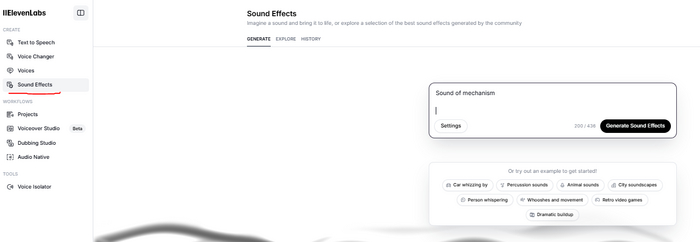

Саунд-дизайн

В общем, тут я однозначно рекомендую ElevenLabs, там есть функция генерации звуковых эффектов до 20 секунд длительностью и примерно 70% звуков в моем видео, сделаны именно там.

Доводим кадры до ума, добавляем саунд-дизайн, склеиваем в любом редакторе наши кадры и вуаля, вы великолепны.

Собственно основное аспекты я рассказал, если возникнут вопросы - в комментариях постараюсь ответить, а может и дополнить пост. Для вас вещал автор канала Верю только трендам. По ссылке как раз ролик, подход к генерации которого разбирал тут. Если вам интересен генеративный контент и вопросы нейронок, буду рад видеть и на канале.

Что я использовал, сколько стоит и чем заменить:

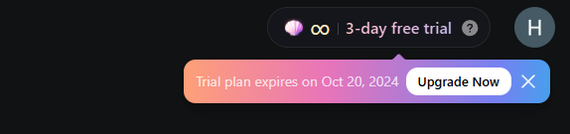

Я пользую платный GPT, самую дешевую подписку MidJourney (10$) и HailuoAi. Когда я генерил ролик, у меня были бонусные часы генерации от Hailuo, да, если сейчас у них купить подписку за 10$, то получаешь 3 дня безлимита, если вам было интересно попробовать и вы хотите прям погрузиться в безлимитные генерации - то шанс реально хороший.

А можно бесплатно? В теории -- да!

Например для генерации кадров можно использовать бесплатный SD - рассказал тут. Но важно помнить, что тот же MJ кинематографичнее. Насколько знаю, есть еще бесплатные версии Flux, но они ограничены по числу генераций.

Hailuo AI доступна бесплатно?

Сейчас - частично да, насколько я вижу, то при авторизации с нового логина, мне дали те же бесплатные 3 дня.

Ну, а базовые версии GPT итак доступны бесплатно. Если с доступом к нему трудности, то всегда есть замечательные сервисы бенчмарка типа llmarena.ru, где вы можете тестировать вообще разные текстовые модели. Но картинки он правда пока не воспринимает для загрузки, но вот с промт-составлением поможет точно.

Если у вас трудности с оплатой, то могу сказать так, сам все оплачиваю через посредников, коих довольно много, и переплачиваю в среднем процентов 10-20, но от суммы в 10$ это не так много.