Лига Сисадминов

Термоинтерфейс на Gigabyte RTX 3060 WINDFORCE OC 12 Gb

Всем привет! Надеюсь размещаю пост в нужном сообществе) Нужны размеры термопрокладок на видеокарту из заголовка. Буду признателен за подсказку.

Философия PowerShell. Часть 4. Интерактивная работа: Out-ConsoleGridView

В первой части мы определили два ключевых понятия powershell: конвейер и объект.

Во второй части я рассказал как объекты взаимодействуют через переменные и конвейер.

В третьей части познакомились с файловой системой и провайдерами.

Сегодня рассмотрим интерактивную работу с данными в консоли.

Дисклеймер. На пикабу нет редактора кода, поэтому картинки и кривое форматирование. В конце поста я размещу ссылки на статью и исходники в github. Приятного чтения.

Out-ConsoleGridView. GUI в консоли PowerShell.

❗ Важно: Все описываемые ниже инструменты требуют PowerShell 7.2 или новее.

Out-ConsoleGridView — это интерактивная таблица, прямо в консоли PowerShell, позволяющая:

просматривать данные в виде таблицы;

фильтровать и сортировать колонки;

выбирать строки курсором — для передачи их дальше по конвейеру.

и многое другое.

Out-ConsoleGridView является частью модуля Microsoft.PowerShell.ConsoleGuiTools. Для его использования сначала нужно установить этот модуль.

Для установки модуля выполните следующую команду в PowerShell:

Install-Module Microsoft.PowerShell.ConsoleGuiTools -Scope CurrentUser

Install-Module загружает и устанавливает указанный модуль из репозитория в систему. Аналоги: pip install в Python и npm install в Node.js.

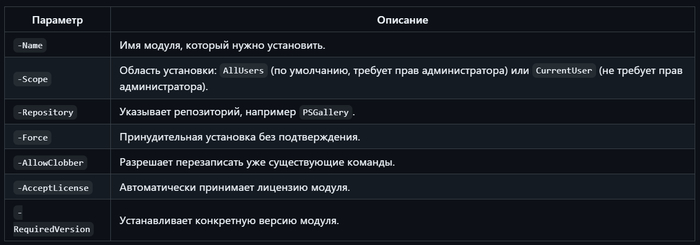

📎 Ключевые параметры Install-Module

После установки вы можете передавать любой вывод в Out-ConsoleGridView для интерактивной работы.

# Классческий пример: вывод списка процессов в интерактивную таблицу:

> Get-Process | Out-ConsoleGridView

Интерфейс:

Фильтрация: Просто начните вводить текст, и список будет отфильтрован на лету.

Навигация: Используйте клавиши-стрелки для перемещения по списку.

Выбор: Нажмите Space для выбора/снятия выделения с одного элемента.

Множественный выбор: Ctrl+A для выбора всех элементов, Ctrl+D для снятия всего выделения.

Подтверждение: Нажмите Enter, чтобы вернуть выбранные объекты.

Отмена: Нажмите ESC, чтобы закрыть окно без возврата данных.

Что умеет Out-ConsoleGridView:

Отображать табличные данные прямо в консоли в виде интерактивной таблицы с навигацией по строкам и столбцам.

Сортировать столбцы по нажатию клавиш.

Фильтровать данные с помощью поиска.

Выбирать одну или несколько строк с возвратом результата.

Работать в чистой консоли без GUI-окон.

Поддерживать большое количество строк с прокруткой.

Поддерживать различные типы данных (строки, числа, даты и пр.).

Примеры использования Out-ConsoleGridView

Базовое использование — показать таблицу с возможностью интерактивного выбора. (checkbox)

Выводится список процессов в интерактивной консольной таблице. Можно фильтровать по имени, сортировать столбцы и выбирать процессы. Выбранные процессы возвращаются в переменную $selected.

Выбор одной строки с обязательным возвратом результата. (radio)

$choice = Get-Service | Select-Object -First 20 | Out-ConsoleGridView -Title "Select a service" -OutputMode Single Write-Host "You selected service: $($choice.Name)"

Пользователь выбирает одну строку. -OutputMode Single запрещает выбирать несколько.

Интерактивное управление процессами:

Вы можете выбрать несколько процессов для остановки. Параметр -OutputMode Multiple указывает, что мы хотим вернуть все выбранные элементы.

Выбор файлов для архивации:

Выбор одного элемента для детального анализа:

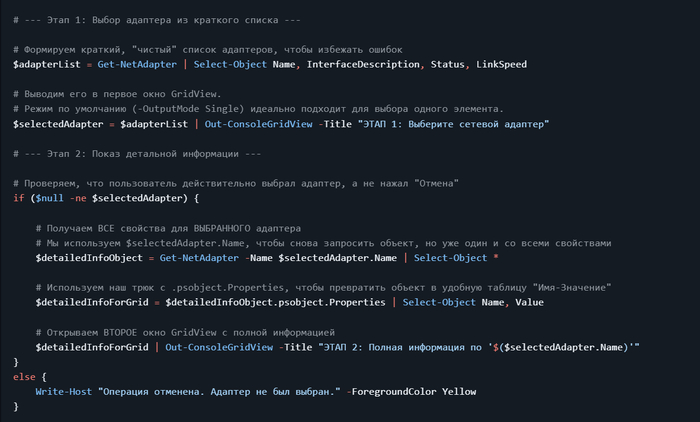

Паттерн "Drill-Down" — от общего списка к деталям с Out-ConsoleGridView

Часто при работе с системными объектами мы сталкиваемся с дилеммой:

Если запросить все свойства для всех объектов (Get-NetAdapter | Format-List *), вывод будет огромным и нечитаемым.

Если показать краткую таблицу, мы потеряем важные детали.

Иногда попытка получить все данные сразу может привести к ошибке, если один из объектов содержит некорректные значения.

Решение этой проблемы — паттерн "Drill-Down" (детализация). Его суть проста:

Шаг 1 (Обзор): Показать чистый, краткий и безопасный список элементов для выбора.

Шаг 2 (Детализация): После того как пользователь выбрал один конкретный элемент, показать ему всю доступную информацию именно по этому элементу.

Практический пример: Создание обозревателя сетевых адаптеров

Задача: Сначала показать краткий список сетевых адаптеров. После выбора одного из них, открыть второе окно со всеми его свойствами.

Готовый код:

Информация о системе.

код скрипта для получения информации о системе: Get-SystemMonitor.ps1

Создание командлета 'Get-SystemMonitor'

Шаг 1: Настройка переменной PATH

Создайте постоянную папку для ваших инструментов, если еще не сделали этого. Например: C:\PowerShell\Scripts

Поместите ваш файл Get-SystemMonitor.ps1 в эту папку.

Добавьте эту папку в системную переменную PATH,

Шаг 2: Настройка псевдонима (alias) в профиле PowerShell

Откройте ваш файл профиля PowerShell:

notepad $PROFILE

Добавьте в него следующую строку:

Set-Alias -Name sysmon -Value "Get-SystemMonitor.ps1"

где sysmon - псевдоним командлета Get-SystemMonitorЕсли вы когда-нибудь переместите папку C:\PowerShell\Scripts, вам нужно будет обновить только переменную PATH, а ваш файл профиля останется без изменений.

Перезапустите PowerShell

Закройте все открытые окна PowerShell и откройте новое. Это необходимо, чтобы система применила изменения как в переменной PATH, так и в вашем профиле.

Код скрипта для установки C:\PowerShell\Scripts в PATH: Add-Path.ps1

Запуск:

Get-SystemMonitor

или конкретный ресурс:

Get-SystemMonitor -Resource users

Реализованы cpu, memory, system, network, users, peripherals

🤝 Поздравляю. Вы создали первый командлет.

Пост на github

Полезно? Подпишись.

Понравилось — ставь «+»

Задавайте вопросы в комментариях 👇👇👇

Удачи! 🚀

Переход на Proxmox (Proxmox GmbH, Vienna, Austria) с Hyper-V by Microsoft и VMware by Broadcom. Часть пятая из многих

Для лиги лени: общеизвестное, душное, НЕ ПРОКАТИЛО.

Часть 1. Общая

Часть 2. Gitlab и Nexus

Часть 3. Ansible и Ansible AWS

Часть 4. Наконец переходим к Proxmox

Часть 5, не запланированная. Обновляем Proxmox с 8.4 до 9.0. Неудачно.

Еще раз поздравляю всех с выходом Proxmox 9.0. Даже статья вышла – ждите сервис пака Upgrade from 8 to 9, читайте Known Issues & Breaking Changes и Known Upgrade Issues.

Скажу сразу.

Я доигрался, пришлось переставлять систему.

5.2 Гб до неправильного обновления и всяких непотребных игр превратились в 8.1 Гб.

Дельта обновления еще 5.3 Гб.

На выходе:

pve-manager/9.0.3/025864202ebb6109 (running kernel: 6.14.8-2-pve)

Что в наличии?

Было: pveversion: pve-manager/8.4.0/ec58e45e1bcdf2ac (running kernel: 6.8.12-9-pve)

стало: pve-manager/8.4.9/649acf70aab54798 (running kernel: 6.8.12-9-pve)

и, после удачного обновления, pve-manager/9.0.3/025864202ebb6109 (running kernel: 6.14.8-2-pve)

Он сказал поехали (и запил водой)

Выполняем по инструкции: pve8to9. Кстати, в pve-manager/8.4.0/ этого скрипта не было.

Получаем:

= SUMMARY =

TOTAL: 42

PASSED: 33

SKIPPED: 6

WARNINGS: 3

FAILURES: 0

Что там?

WARN: updates for the following packages are available: pve-cluster

Что я могу сказать, кроме того что удивительное рядом?

apt update

apt list --upgradable –a

pve-cluster/stable 8.1.2 amd64 [upgradable from: 8.1.0]

pve-cluster/stable,now 8.1.0 amd64 [installed,upgradable to: 8.1.2]

Что происходит, и почему вчера не обновился pve cluster, при отсутствии кластера?

Примечание. После того, как я уронил систему, переставил с ноля, и обновился еще раз, проблема ушла, обновился и стал предлагать обновиться:

pve-cluster/stable 9.0.6 amd64 [upgradable from: 8.1.2]

Следующее предупреждение: WARN: systemd-boot meta-package installed but the system does not seem to use it for booting. This can cause problems on upgrades of other boot-related packages . Consider removing 'systemd-boot'

Сомнительно, но окей.

Третье предупреждение: WARN: The matching CPU microcode package 'amd64-microcode' could not be found! Consider installing it to receive the latest security and bug fixes for your CPU.

и не предупреждение, а напоминание:

SKIP: NOTE: Expensive checks, like CT cgroupv2 compat, not performed without '-- full' parameter

А ?? Почему свежий инсталлятор PVE сам не поставил amd64-microcode, если считает их необходимым?

Понятно, что статья:

New AMD Zen 6 Linux Patches Posted - Confirming Up To 16 Memory Channels со ссылкой на вчерашний патч вышла не просто так, но все же.

Примечание. Это не связанные вещи. Обновление вышло для ядра для 2.5 новых фич.

Что там дальше по инструкции?

меняем репозитории локально

sed -i 's/bookworm/trixie/g' /etc/apt/sources.list

sed -i 's/bookworm/trixie/g' /etc/apt/sources.list.d/pve-enterprise.list

и, поскольку у меня сделан Nexus для проксирования репозиториев, не забываем добавить там новые данные

В инструкции, конечно, про это ни слова.

Дальше все по инструкции - apt update, получаем (со второй попытки) 581 packages can be upgraded.

apt list --upgradable | grep 8.4

получаем (со второй попытки(

proxmox-ve/stable 9.0.0 all [upgradable from: 8.4.0]

pve-manager/stable 9.0.3 all [upgradable from: 8.4.9]

qemu-server/stable 9.0.16 amd64 [upgradable from: 8.4.1]

Вот что странно. Я Ceph не использую, не люблю, и репозиторий с ним отключил.

но не тут то было – и в инструкции написано, что

Note: At this point a hyper-converged Ceph cluster installed directly in Proxmox VE must run Ceph 19.2 Squid, otherwise you need to upgrade Ceph first before upgrading to Proxmox VE 9 on Debian 13 Trixie!

Но в выборке apt list --upgradable | grep ceph есть

ceph-common/stable 19.2.3-pve1 amd64 [upgradable from: 17.2.8-pve2]

ceph-fuse/stable 19.2.3-pve1 amd64 [upgradable from: 17.2.8-pve2]

Пропустим и идем дальше:

apt dist-upgrade

The following NEW packages will be installed:

proxmox-kernel-6.14

proxmox-kernel-6.14.8-2-pve-signed

After this operation, 637 MB of additional disk space will be used.

За пять минут первая попытка обновления свалилось в ошибки:

Job for pvedaemon.service failed.

See "systemctl status pvedaemon.service" and "journalctl -xeu pvedaemon.service" for details.

Job for pvestatd.service failed.

See "systemctl status pvestatd.service" and "journalctl -xeu pvestatd.service" for details.

Job for pveproxy.service failed.

See "systemctl status pveproxy.service" and "journalctl -xeu pveproxy.service" for details.

Job for pvescheduler.service failed.

See "systemctl status pvescheduler.service" and "journalctl -xeu pvescheduler.service" for details.

Пустая, неделю назад установленная, ничем не нагруженная нода не может обновиться на ровном месте.

НУ ОТЛИЧНО.

В журналах:

proxmox pvedaemon[]: Compilation failed in require at /usr/share/perl5/PVE/API2/Cluster.pm line 14.

Сказать, что я ничего не понял в первые пару минут, это ничего не сказать.

Ребутнулся, и удивился еще больше.

Было pve-manager/8.4.9/() (running kernel: 6.8.12-9-pve)

Стало pve-manager/8.4.9/() (running kernel: 6.14.8-2-pve)

Ядро обновилось. PVE нет.

pve8to9 выдало ошибки:

Attempt to reload PVE/HA/Config.pm aborted.

Compilation failed in require at /usr/share/perl5/PVE/HA/Env/PVE2.pm line 20.

BEGIN failed--compilation aborted at /usr/share/perl5/PVE/HA/Env/PVE2.pm line 20.

Compilation failed in require at /usr/share/perl5/PVE/API2/LXC/Status.pm line 24.

BEGIN failed--compilation aborted at /usr/share/perl5/PVE/API2/LXC/Status.pm line 29.

Compilation failed in require at /usr/share/perl5/PVE/API2/LXC.pm line 28.

BEGIN failed--compilation aborted at /usr/share/perl5/PVE/API2/LXC.pm line 28.

Compilation failed in require at /usr/share/perl5/PVE/CLI/pve8to9.pm line 10.

BEGIN failed--compilation aborted at /usr/share/perl5/PVE/CLI/pve8to9.pm line 10.

Compilation failed in require at /usr/bin/pve8to9 line 6.

BEGIN failed--compilation aborted at /usr/bin/pve8to9 line 6.

В моем случае проще все переставить и повторить процедуру, чем разбираться, что пошло не так.

Почему так?

Может потому, что я прописал только:

deb http://my.local.proxy:8081/repository/Debian3/ trixie pve-no-subscription

Но не прописал Nexus прокси для:

trixie main contrib

trixie-updates main contrib

trixie-security main contrib

Следите за тем, что у вас в проксях и в /etc/apt/sources.list

Вопрос «зачем так сделано» остается открыт. Странный подход, что обновления не идут из одного источника, и есть риск получить проблем с зависимостями, когда Debian обновится, а Proxmox еще нет.

Итого

Доигрался я на скрипке. Необходимо переставить 8.4 еще раз, проверить настройки в /etc/apt/sources.list , перепроверить Nexus, и сделать обновление еще раз.

Потому что по умолчанию в /etc/apt/sources.list стоит то, что выбрано при установке. Я выбрал US – получил

deb http://ftp.us.debian.org/debian bookworm main contrib

deb http://ftp.us.debian.org/debian bookworm-updates main contrib

# security updates

deb http://security.debian.org bookworm-security main contrib

Вторая попытка обновления прошла удачно.

Очень неприятно то, что в процедуре обновления есть несколько пунктов для выполнения вручную.

Это чтение какой-то длинной страницы, выбор языка два раза, и напоследок вопросы «мы тут сервисы обновляем, вам их сразу перезагрузить или не сразу».

Само обновление после этих вопросов занимает где-то полчаса, и в середине процесса, где то на 98%, спрашивает еще пару вопросов про настройки, новые вы хотите или старые.

Что дальше писать, я еще не решил.

Или про Proxmox VE API , или воспользоваться полезным советом из комментариев и обновить Ansible нормально.

@editors, как сюда тег Proxmox добавить? не идет у меня этот каменный цветок.

Нужен бокс Usb под 2 Nvme с аппаратныv raid 1

Айтишники подскажите, второй день не могу найти девайс...

Что-то небольшое, надежное. .Спасибо

Переход на Proxmox (Proxmox GmbH, Vienna, Austria) с Hyper-V by Microsoft и VMware by Broadcom. Часть четвертая из многих

Для лиги лени: общеизвестное и душное.

Часть 4. Наконец переходим к Proxmox

Поздравляю всех с выходом Proxmox 9.0. Даже статья вышла – ждите сервис пака Upgrade from 8 to 9, читайте Known Issues & Breaking Changes и Known Upgrade Issues.

Первый взгляд: чем отличается Proxmox от Broadcom ESXi и Microsoft Hyper-V?

Первый взгляд: требуемое место для установки.

Broadcom ESXi до недавнего времени отлично (с оговорками) работал с 32 Гб хоть USB флешки, хоть SD карточки, в псевдорейде, и без. При этом, хотя с версии 6.5 флешка умирала за 3-6 месяцев, спасибо криворуким разработчикам, но сам гипервизор, и виртуальные машины на нем, продолжали работать до планового выключения или миграции (обычно). Иногда с проблемами.

RAID для установки? Не нужен. Если умерла флешка, то берется новая, на нее за 10 минут ставиться ESXi той же версии. За еще 5 минут применяется или бекап конфигурации (родной, теплый, встроенный бекап, не забывайте делать), или profile с vCenter, или, если вы озаботились, то прогоняете хоть powershell (powercli) скрипт, хоть что угодно, и система снова в строю.

Можно и PXE boot делать, можно и FC \ iSCSI boot. Со всеми минусами сочетания FC и кривых рук. Известная история, как отформатировать раздел с виртуальными машинами, привлекая внимание санитаров.

С Microsoft Hyper-V другая история. Хотя там и был отдельный дистрибутив с Hyper-V only, но я не видел, чтобы его в таком виде как-то массово использовали. Так что готовьте 60-100 гигабайт на загрузку плюс данные плюс логи.

RAID для установки? Нуууу .. it depends on. Проблема выбора не очевидна, но.

Аппаратный рейд отнимает PCIe слот, снижает производительность NVME SSD дисков (ссылка 1, ссылка 2), и очень хочется заменить его на PCIe SAS или SATA переходник или как-то еще уйти от этого.

Внутри Microsoft Windows давно существует два подхода к RAID – это софтовый рейд от MS, и storage space \ storage space direct (этот требует лицензии DC).

Софтовый рейд работает, но для настройки зеркалирования «и загрузчика и раздела восстановления» нужно идти в diskpart и делать там всякое, причем diskpart еще и не автоматизируется (штатно, конечно можно написать свой обработчик). Сделать можно, и это работает, но в эксплуатации решение «вроде все ок, но как-то так себе». Разовая, но все равно ручная работа.

PXE и прочие варианты загрузки, конечно, тоже есть. Бекап – есть. Нужно ли при этом иметь RAID ? Не знаю. 20 лет назад, во времена 2003 \ 2008 Windows и дисков по 74 Гб, было проще сделать RAID. Сейчас мне проще настроить встроенный бекап, сделать один раз, и экспортировать задание со скриптом. Хотя это все равно колхозное решение.

Установленный для тестов и этой статьи в виртуальную машину Proxmox 8.4 занял 5 Гб, до установки обновлений, агентов, прочей обвязки.

RAID для установки? Нуууу .. it depends on. Проблема в чем. Встроенного бекапа конфигурации нет. Есть какие-то скрипты непонятной годности, их еще и читать надо. Конечно, есть LVM, но его настройка описана «как-то так». Можно заранее сделать mdadm boot on RAID1, но это все равно ручная работа и по перезагрузке, и по восстановлению. И BIOS надо настроить.

Эти все моменты «как бы есть, но как бы и не понятно», стали одним из поводов к написанию заметок, и поводом посидеть, подумать еще раз, погонять сценарии отказа в виртуальной среде. На физике было решено максимально просто: диски новые, сейчас делаем первую итерацию, для наших задач это не так важно, потом переделаем.

FEEL THE POWER OF AGILE! (нет)

Первый взгляд: Остаток используемого места.

Если у вас не отдельные диски «только под загрузку», и не планируется vSAN или Storage space direct, и нет системы хранения данных, то возникает вопрос «что делать с остальным местом на дисках».

Broadcom ESXi решает эту задачу в лоб – отделяет себе 138 Гб, а дальше делайте что хотите, только под vSAN такое не используйте.

Microsoft Hyper-V решает эту задачу не менее прямолинейно – делайте что хотите, но место под ОС будьте добры предоставить.

С PVE Proxmox Virtual Environment все .. не так очевидно.

Для тестов был сделан диск на 75 Гб, тонкий (динамический)

Если при установке сделать LVM, и потом посмотреть, что там вышло, то получим:

lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTS

sda 8:0 0 70G 0 disk

├─sda2 8:2 0 512M 0 part /boot/efi

└─sda3 8:3 0 69.5G 0 part

├─pve-swap 252:0 0 8G 0 lvm [SWAP]

├─pve-root 252:1 0 27.4G 0 lvm /

├─pve-data_tmeta 252:2 0 1G 0 lvm

│ └─pve-data 252:4 0 23.5G 0 lvm

└─pve-data_tdata 252:3 0 23.5G 0 lvm

└─pve-data 252:4 0 23.5G 0 lvm

lvdisplay покажет:

--- Logical volume ---

LV Name data

VG Name pve

LV Size <23.50 GiB

--- Logical volume ---

LV Path /dev/pve/swap

LV Name swap

VG Name pve

LV Size 8.00 GiB

--- Logical volume ---

LV Path /dev/pve/root

LV Name root

VG Name pve

LV Size 27.37 GiB

Понятно, что не понятно.

Если смотреть из GUI, то на LVM свободно 9 Гб, а на томе Data свободно все 23.

Как пишут, есть нюанс:

временные файлы при копировании создаются в корневом разделе в /var/tmp/

Но, у меня /dev/mapper/pve-root создался размером 27G, занято всего 3.0G, так что переживу.

Давайте посмотрим, что с этим можно сделать, положу туда стопку ISO !

В GUI это все видно как:

/dev/mapper/pve-root виден как Storage 'local' on node 'proxmox1'

И второй виден как Storage 'local-lvm' on node 'proxmox1'

при этом монтируется это все ничуть не очевидно, например

ISO images в GUI это /var/lib/vz/template/iso

CT templates в GUI это /var/lib/vz/template/cache

CT templates позволяет закачивать только .tar.xz файлы, точнее закачивать то можно хоть ISO, но закачивать надо с именем .tar.xz , ну что за хрень.

Удалить файлы пачкой из GUI нельзя, создать папок под свои представления о прекрасном нельзя, что такое то. ГДЕ СВОБОДА?

В целом GUI не очень понятный, надо сидеть пытаться понять логику авторов.

Если я иду в node/disks, то вижу диски. Ок, понятно.

Если я иду в node/disk/lvm, то вижу, что создана LVM группа PVE, из трех томов, и свободно 9 Гб. Ну, окей.

Если я иду в node/disk/ lvm-thin, то вижу пустой pool, и .. и что мне с этим знанием делать?

Интересное наблюдение. Удаление файлов, хоть из GUI, хоть из CLI, не освобождает место на диске с точки зрения гипервизора. То есть изнутри VM место есть, но дальше, при попытке его сжать, он как был раздут до 29333222111, так и останется, вне зависимости от ключей для Optimize-VHD

Решение гуглится за минуту,

apt install zerofree

но «из коробки» ничего этого нет. Горько мне, горько.

Первичные исправления и обновления.

Для того, чтобы это австрийское изделие заработало в продуктиве, нужно:

Настроить на Nexus – proxy repo

Поменять VLAN и дефолтный IP. У меня оно взяло IP из первичных настроек DHCP, которого я не ожидал.

Настроить DNS

Настроить нужные pero на proxmox

Настроить NTP

И, наконец, обновиться.

Сменить настройку в CLI по умолчанию, куда прописался старый IP.

Сделать нормальную авторизацию, то есть дома – по сертификату с паролем, а в продуктиве, конечно, AD/Kerberos

Убрать надпись при входе

Вроде ничего не забыл, про пересылку логов событий, установки антивирусов и прочих Тайнос Агентос пусть безопасность думает, про Zabbix пусть мониторинг телеграфирует или графанирует.

Сначала сделаю руками. Конечно, надо сразу делать через Ansible.

Настроить на Nexus – proxy repo

Это самое простое.

Settings – Repo – create proxy - Distribution to fetch e.g. bionic : bookworm для 8.4, trixie для 9.

Save – done

Зачем? Чтобы ваши гипервизоры не ходили в интернеты. Но, если вам ОК, то пусть ходят.

Не забудьте выписать URL.

Очень смешно получается, если прописать не bookworm, а bionic, и прописать этот репозиторий в PVE. Обязательно попробуйте.

Поменять VLAN и дефолтный IP.

У меня оно взяло IP из первичных настроек DHCP, которых я не ожидал

Здесь, если делать руками, все максимально просто.

Открываем документацию, раздел Network Configuration, раздел Default Configuration using a Bridge, и делаем.

Для продуктива, конечно, открываем пример

Use VLAN 5 with bond0 for the Proxmox VE management IP with traditional Linux bridge ,

думаем, читаем, делаем.

nano /etc/network/interfaces

и даже делаем

If you made manual changes directly to the /etc/network/interfaces file, you can apply them by running

ifreload -a

Но при этом в GUI, во вкладке localnetwork, все равно откуда-то подтягивается старый адрес для vmbr0, причем в поле COMMENT, если зайти в сети хоста.

Я поленился его искать в описаниях, и исправил из GUI, и это был alias, куда я вообще смотрел.

Настроить DNS

Тут тоже ничего нового, nano /etc/resolv.conf

Настроить нужные pero на proxmox

nano /etc/apt/sources.list

nano /etc/apt/sources.list.d/ceph.list

nano /etc/apt/sources.list.d/pve-enterprise.list

Надеюсь, вы поняли, что надо туда прописать, после настройки Nexus

Настроить NTP

Нет ничего проще, открыли документацию, Time Synchronization, настроили.

nano /etc/chrony/chrony.conf , и посмотрели: chronyc tracking

В изолированной среде, разумеется, за временем придется идти или к NTP proxy, или к контроллерам домена.

И, наконец, обновиться.

Было: pveversion

pve-manager/8.4.0/ (running kernel: 6.8.12-9-pve)

стало

pve-manager/8.4.9/ (running kernel: 6.8.12-9-pve)

Вот что неприятно, так это то, что в

http://download.proxmox.com/debian/pve/dists/bookworm/InRelease

дату обновлений видно, а что там обновлено и исправлено – найти так сразу нельзя.

В changelog смотреть – развлечение тоже то еще.

Сменить настройку в CLI по умолчанию, куда прописался старый IP.

Это, понятно, /etc/hosts

Сделать нормальную авторизацию, то есть дома – по сертификату с паролем, а в продуктиве, конечно, AD/Kerberos

Тут тоже капитанство,

nano ~/.ssh/authorized_keys и готово

Во всех остальных случаях надо читать документацию, Syncing LDAP-Based Realms

Убрать надпись при входе

Тут тоже никакой магии. Прочитать это или это, и сделать. Или, все то же самое, но через pve-nag-buster, или, если вы совсем ленивы, то читаете тред на реддит, и делаете. Вплоть до рецепта remove_nag.yml

615-я строка, кому интересно, res.data.status.toLowerCase() \!== 'active'

Литература

Changing the default size of the ESX-OSData volume in ESXi 7.0

Change ESXi 7 System Storage Installation Size

boot on RAID1

Расширение корневого раздела (LVM) в Proxmox

Proxmox - Распределение дискового пространства

Переключение на бесплатные репозиторий в Proxmox VE

В следующей серии:

Actions step-by-step, Proxmox VE API

надеюсь, теги Proxmox и Ansible наконец добавятся