Искусственный интеллект

Перевод игр с помощью AI и n8n для Indie GameDev

Думаю, многим инди-разрабам это знакомо: "Ты вложил в свою игру всю душу и тысячи часов. Ты хочешь, чтобы в нее поиграл весь мир", но для этого нужны переводы, которые порой стоят больше чем вся разработка ранее. Я не GameDev разработчик, но я вижу, как многие соотечественники сталкиваются с этой проблемой. Я решил потратить пару часов и свои навыки в разработке цепочек автоматизации n8n, для того, чтобы отечественная инди-разработка могла иметь возможность получить средненький перевод и существенную экономию на данном процессе.

Почему нельзя просто закинуть текст в ChatGPT?

Первая мысль, конечно, взять все реплики и тексты из игры и просто скормить их нейросети. Я пробовал. Не работает оно так :(

Дело в том, что в играх всё решает контекст. AI без понятия, что значит одно и то же слово в разных ситуациях:

Слово Fire — это кнопка «Стрелять»? Заклинание «Огонь»? Или кто-то у костра кричит «Огонь!»?

Слово Rose — это имя персонажа Роуз или цветок роза?

Фраза Follow me — это приказ компаньону «Следуй за мной» или кнопка в меню «Подписаться»?

Без контекста даже самый умный AI будет постоянно ошибаться. Вы потратите больше времени на исправление его косяков, чем если бы переводили сами.

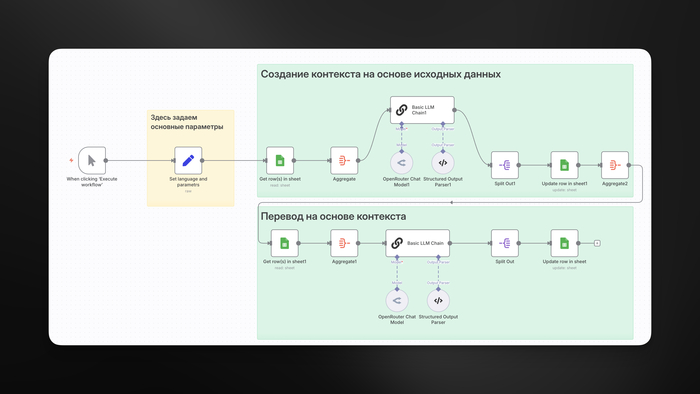

Двухэтапный процесс в n8n

Я понял, что мне нужен не просто переводчик, а система, которая сначала поймет контекст, а уже потом будет переводить. Я собрал ее в n8n, и она состоит из двух простых модулей.

Как завести свой n8n можете почитать у меня в заметках тут.

Шаг 1: Готовим таблицу и AI-аналитика

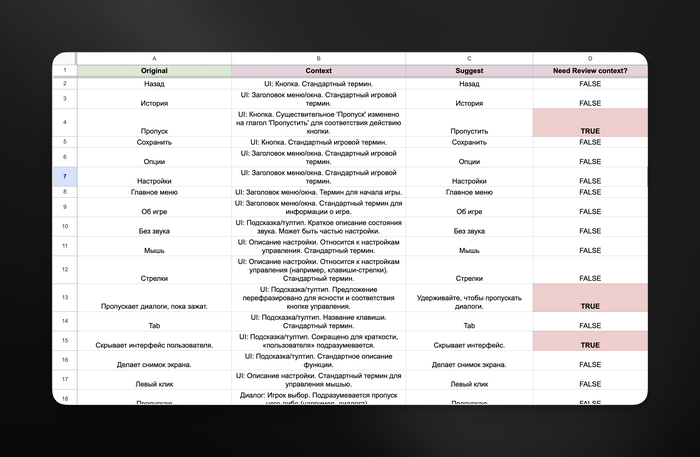

Все начинается с обычной Google-таблицы. В ней несколько колонок: ID (номер строки), Original (оригинальный текст), Context (пока пустая), Suggest (пустая), Translation (тоже пустая) и Needs Review (один для контекста, другой уже для самого перевода).

Дальше я запускаю первую часть своего workflow в n8n. Он берет все строки, по сути изначально у нас заполнена только колонка Original, и отправляет их в нейросеть. Но я прошу ее не переводить текст. Я прошу ее сделать другое:

«Ты — специалист по локализации игр. Посмотри на эту строку и скажи, что это, скорее всего: кнопка в интерфейсе, реплика персонажа, название предмета и т.д.».

AI проходит по всем строкам и заполняет колонку Context и Suggest.

Suggest помогает подсветить спорные моменты, где LLM может галлюцинировать и понимать слово иначе. Главная проблема решена еще до начала самого перевода (по крайней мере большая её часть).

Шаг 2: Запускаем AI-переводчика с подсказками

Теперь, когда у нас есть контекст, начинается второй этап. n8n снова идет по таблице, но на этот раз запускает перевод. И промпт (инструкция) для нейросети здесь уже гораздо шире. Я даю ей:

Краткую справку об игре: жанр, сеттинг, тон повествования.

Контекст конкретной строки: например, UI: Кнопка.

Четкие правила: как обращаться с переменными вроде {player_name} и, самое главное, когда просить о помощи. Если AI не уверен в переводе, адаптирует сложную шутку или идиому, он ставит в колонке Need Review флажок TRUE.

Цепочка в текущем виде делает 90% рутинной работы, а сложные моменты оставляет для проверки человеком.

Исходники данного воркфлоу и используемые Prompt's можете найти вот тут.

Про экономию

Возьмем небольшую игру на 50 000 слов.

Работа с агентством: обойдется примерно в 5-10 рублей за 1 слово и займет 20-30 дней. Итого: 375 000 рублей. Математику строил на основе информации по расценкам различных фриланс площадок.

Мой workflow в n8n: запросы к нейросети обойдутся примерно в 1-3$ (165 000 токенов). Весь процесс займет пару часов на автоматический прогон и еще день-два на проверку строк, которые AI пометил флажком.

Экономия – больше 99%. Но, есть естественно одно "но".

Что важно понимать

Конечно, это не волшебная кнопка, хотя очень хотелось бы. Перевод получается посредственный. Чтобы сделать прям совсем идеальный, нужно запарываться над RAG (например поддержку длинных диалогов и полотна сюжета), а также OCR определение на основе интерфейса (помимо текстового контекста, еще и скрин из игры где этот текстовый элемент находился). По моим расчетам, такая штука обойдется уже в 100$+ чисто на запросах в AI модели.

Это не полная автоматизация. AI делает основную работу, но финальная проверка и ответственность всё же за разработчиком.

Качество зависит от вас. Чем лучше вы опишете игру и термины для AI, тем меньше вам потом придется исправлять.

Нужна реализация потоков. Сейчас в workflow нет разделения на потоки, лучше конечно за раз обрабатывать не более 50 строк (можно и больше, но помните про контекстное окно самих LLM). Уверен, что те, кто захочет развернуть у себя нечто подобное, смогут легко разобраться в особенностях работы n8n и достроить эту цепочку конкретно под свои нужды.

Это не для ААА-игр. Для огромного проекта со сложным литературным языком все еще нужен профессиональный переводчик. Но для инди-игры, чтобы выйти на новые рынки и получить начальный фидбэк, этого более чем достаточно.

Какие модели рекомендую использовать

Gemini 2.5 Flash Lite (дешёвая, хорошо в English и другие популярные языки);

GPT 5 Mini (подороже, чуть лучше качество, хорошо переводит в различные языки);

Можете пробовать совсем дорогие и навороченные модели по типу Gemini 2.5 Pro или обычную GPT-4o / GPT-5, но цена сразу взлетает в несколько раз и мне не совсем понятна метрика цена/качество на выходе. Подобные эксперименты на существенных объемах по переводу не проводил. Если среди нас есть энтузиасты, которые подобные вещи уже тестировании, буду рад услышать их мнение в комментариях.

Вместо заключения

Собственно, как-то так. Вот такой подход у меня получился и я очень хотел бы, чтобы он позволял маленькой команде или даже одному разработчику донести свою игру до аудитории по всему миру. И это, на мой взгляд, и есть самое правильное применение подобных технологий – делать то, что раньше казалось невозможным, доступным.

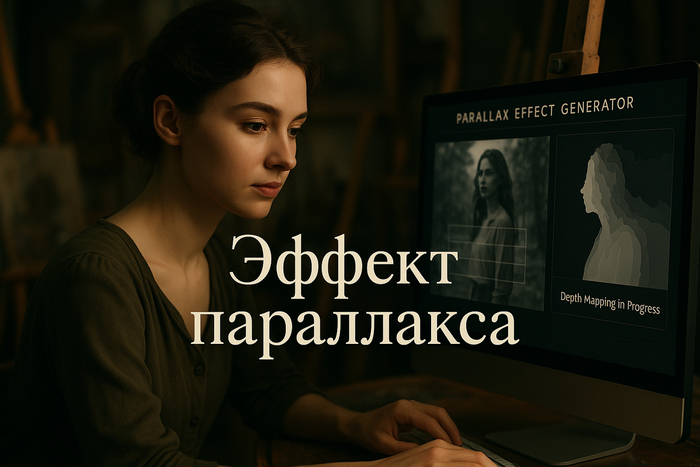

Как добавить видеоэффект параллакса на фото онлайн: пошаговая инструкция

Хотите узнать, как легко и быстро добавить видеоэффект параллакса на фото? Наша пошаговая инструкция поможет вам достичь качественных результатов онлайн. С помощью простых инструментов и ясных шагов создание впечатляющего эффекта станет доступным каждому. Применив эти методы, можно значительно улучшить визуальную привлекательность ваших изображений придав им динамики.

Преобразование обычного фото в динамичное видео с параллаксом

Статичные фотографии легко превращаются в живые клипы с помощью нейросетей. Параллакс-эффект добавляет глубину: кажется, будто изображение стало объемным, а передний план отстает от фона — словно в кино. Делимся эффективными инструментами и пошаговой схемой.

Где пригодится параллакс-эффект и зачем его использовать

Параллакс визуально создает 3D-ощущение, даже если фото изначально двумерное. Перед объекты смещаются медленнее, фон — быстрее, что напоминает кинематографичный переход.

Области применения:

Социальные сети: оживленные сторис для Instagram, TikTok

Рекламные кампании: креативы для контекстной рекламы

Презентации: анимированные слайды вместо статичных изображений

Одностраничные сайты: динамичные фоны для лендингов.

Если раньше подобную анимацию собирали в After Effects за несколько часов, то теперь нейросети делают все за пару минут.

Российские Telegram-боты для параллакса

Существуют отечественные решения, которые позволяют добиться аналогичного эффекта. Для сложных задач с видеороликами подойдет бот с VEO 3. С его помощью из обычных картинок создаются впечатляющие кинематографичные видео.

Простой метод: Immersity AI

Immersity AI — удобный сервис для начинающих. Регистрация не требуется, сразу доступно 100 бесплатных попыток.

Порядок действий:

Открываем сайт Immersity AI

Загружаем изображение (желательно с четким разделением объектов и заднего плана)

В меню выбираем функцию "Parallax Effect"

Ожидаем обработку от 30 до 60 секунд

Сохраняем получившийся видеоролик.

Совет: важно, чтобы фото было высокого качества. Сложные сцены или размытый задний план могут дать некорректный результат.

Пробовал на портретах и пейзажах. На портретах лицо остается на месте, а фон мягко сдвигается. Пейзажи особенно хороши, если есть движущаяся вода или облака.

Больше возможностей с Runway

Сервис Runway позволяет более гибко управлять результатом. Здесь доступна настройка каждого слоя в отдельности.

Пошаговый процесс:

Создаем аккаунт на Runway (есть бесплатная версия)

Открываем новый проект → "Image to Video"

Загружаем исходное изображение

С помощью Motion Brush отмечаем нужные области

Определяем направление и темп анимации

Включаем Camera Motion для создания параллакс-эффекта

Motion Brush — главная особенность инструмента. Можно выделить по отдельности волосы, элементы одежды или задний план. Каждой части задается свой путь и скорость движения.

Итог выглядит более кинематографично. Особенно если корректно настроить глубину резкости: передний план остается резким, а задний — уходит в динамичное размытие.

Для сложных задач выбираю Runway. Пусть после бесплатного лимита сервис становится платным, результат действительно впечатляет.

Типичные ошибки и как их обойти

За время работы сталкивался с разными промахами. Вот самые частые:

Неудачная исходная фотография: Размытые контуры объектов лишают всю работу смысла. Искусственный интеллект не отличает, где человек, а где фон. В итоге вместо объемного эффекта появляется визуальное "желе".

Как исправить: использовать снимки с четкими и контрастными деталями. Портрет на свежем воздухе предпочтительнее, чем в помещении с однотонными стенами.

Слишком высокая скорость: Хочется добавить зрелищности — выкручиваешь скорость на максимум. В результате анимация становится слишком резкой и неприятной для глаз.

Как исправить: Идеальная скорость: 20-30% от верхнего значения. Параллакс лучше едва заметен, словно кадр слегка «дышит».

Ошибочное направление движения: Все просто — фон всегда должен двигаться медленнее, чем объекты спереди. Если перепутать — изображение теряет объем, и мозгу сложно его воспринимать.

Как исправить: тестируй оба варианта и оставляй тот, который выглядит естественнее.

Создание видео без учета соотношения сторон: Квадратное фото для Instagram и горизонтальное для YouTube требуют разных настроек. Одни параметры не подойдут для всех платформ.

Как исправить: сразу адаптируй изображение под нужную соцсеть.

Когда сталкиваюсь с необычными задачами, часто обращаюсь на форум по нейросетям — там обсуждают сложные примеры, делятся лайфхаками и опытом по обработке проблемных фото.

Немного лайфхаков по работе с видео

Скрытие сложных областей: Иногда нейросеть ошибается с выделением границ. Волосы могут сливаться с фоном или, наоборот, отделяться неестественно.

Совет: применяй ручную доработку в Runway

Используй опции ручной доработки — кистью можно аккуратно откорректировать маску движения. На это уйдет всего пара минут, зато итог получится гораздо чище.

Сочетание эффектов: Параллакс эффект особенно хорошо работает в паре с плавным zoom-движением. Фон смещается по горизонтали, а кадр потихоньку увеличивается — выходит почти как в кино.

В PixVerse доступны готовые настройки для подобных приемов. Качество неидеальное, но для срочных роликов вполне подойдет.

Коррекция цвета после нейросетей

Иногда после работы нейросети цвета становятся неестественными, особенно это заметно на коже.

Решение простое: быстрая коррекция цвета через любой редактор. Бесплатная DaVinci Resolve подойдет отлично.

Что в итоге

Параллакс заставляет статичные снимки буквально оживать. Создание занимает не часы, а считанные минуты.

Ключевые инструменты для создания видео с эффектом параллакса:

Immersity AI — для быстрого результата

Runway — для точной доработки

Telegram-боты — для простых задач

Главный принцип:

Качество исходного снимка — это 70% успеха. Лучше сразу потратить время на хорошее фото, чем потом долго исправлять недостатки.

Дальнейшие шаги

Пробуй разные изображения: архитектуру, природу, портреты.

Каждый жанр требует индивидуальных настроек — экспериментируй!

Полет над Нижним Новгородом (Sora 2)

Промпт: «полет над Нижним Новгородом (город в России).

Важно: в приложении Sora 2 можно делать ремейки, то есть видео на основе того, что уже сделал кто-то другой. Это видео — пример тому. То есть в ленте было крутое видео с полетом, а я просто сделал ремейк, указав другую местность полета.

Какими нейронками кто пользуется? Расскажите, интересно.

55 букв. Искусственный интеллект определил самое длинное слово в русском языке

Институт им. Пушкина с помощью искусственного интеллекта определил самое длинное слово в русском языке: это прилагательное из 55 букв. И звучит оно так: «тетрагидропиранилциклопентилтетрагидропиридопиридиновые».

Ведущие телеканала и радио РБК попытались повторить его. Что из этого вышло — смотрите в нашем выпуске.

Как сделать плавное видео из фото: современные способы морфинга картинок с помощью нейросетей

В этой статье мы подробно рассмотрим, как сделать плавное видео из фото, используя современные способы морфинга картинок с помощью нейросетей. Узнайте о лучших инструментах и методах для создания динамических визуальных эффектов, которые способны удивлять своей четкостью и реалистичностью.

Как оживить фото за несколько минут: морфинг изображений в видео 2025

Создать плавный видеоролик из обычной фотографии не так просто, как кажется. Многие сервисы выдают резкую и неестественную анимацию, которая не радует глаз. Но существуют технологии, которые позволяют превратить статичную картинку в динамичный клип с натуральными движениями.

Почему стандартные методы не дают качественного результата

Традиционный морфинг строится по простому принципу: две картинки постепенно переходят друг в друга. На словах — легко, на деле — сплошное разочарование.

Главная трудность — программа не различает глубину и структуру объектов, она "видит" только набор пикселей. Из-за этого лица и другие элементы выглядят странно, а движения получаются ненатуральными.

Современные алгоритмы с нейросетями анализируют объем, свет, перспективу, форму предметов. Благодаря этому итоговое видео заметно отличается от простых решений — картинка выглядит живой и реалистичной.

Есть и другая проблема — ограничения сервисов. Бесплатные нейросетевые платформы обычно сокращают длительность ролика до нескольких секунд, а полноценные профессиональные инструменты стоят дорого.

Морфинг через нейросеть: как быстро получить плавную анимацию

Быстрее всего добавить движение в фото помогут ИИ-платформы. Они автоматически превращают статическую сцену в видеоролик.

Пошагово процесс выглядит так:

Загружаешь нужное фото на платформу

Определяешь, какое движение требуется, или просто описываешь задачу словами

Искусственный интеллект создает анимацию обычно за минуту

Сохраняешь полученное видео

Часто использую бота для работы с Kling AI — никаких VPN и удобная оплата в рублях. Kling отлично справляется с портретами и предметами, придавая им естественную динамику.

В результате видео выходит куда реалистичнее, чем при обычном морфинге: нейросеть учитывает законы физики и не искажает форму объектов.

Расширенные техники анимации

Иногда базовой анимации недостаточно — хочется получить эффект превращения или сложной трансформации.

В этом случае пригодятся специальные программы. Vidu 2.0 позволяет управлять каждым моментом морфинга и создавать детальные переходы. Filmora дает расширенные инструменты для обработки и доработки видео.

Лучшие результаты дает сочетание нескольких сервисов

Шаг 1: Подготовка исходников

Выбирай изображения с похожим строением и композицией. Для превращения одного портрета в другой лица должны быть развернуты в одну сторону и быть схожих размеров.

Шаг 2: Генерация промежуточных кадров

Современные нейросети способны создавать недостающие кадры между двумя картинками. В итоге получаешь плавную анимацию без резких скачков.

Шаг 3: Финальная доработка

Добавление стабилизации, цветовой коррекции и звука превращает обычную демонстрацию в полноценный видеоролик.

Если интересуют необычные эффекты, загляни на форум по нейросетям — там можно найти подробные разборы и готовые решения для сложных задач.

Типичные ошибки при создании морфинга и как их избежать

Первая ошибка — неподходящие исходные изображения. Часто берут слишком разные картинки и удивляются неудачному результату. Например, изменить мужское лицо на женское гораздо сложнее, чем поменять выражение одного и того же человека.

Вторая ошибка — игнорирование света. Если на одном фото свет падает слева, а на другом — справа, итоговый переход выйдет неестественным. Искусственный интеллект не сможет органично соединить такие кадры.

Третья ошибка — короткая длительность морфинга. Переходы за 1-2 секунды выглядят резко. Оптимальная продолжительность — от 3 до 5 секунд для мягкой смены образа.

Четвертая ошибка — не то разрешение. Большинство платформ поддерживают квадратный формат 1:1. Если загрузить горизонтальный кадр, он может исказиться или обрезаться.

Пошаговый алгоритм работы:

Приводи все изображения к одинаковым параметрам и формату

Проверь, что объекты совпадают по положению и размеру

Устанавливай длительность не менее 3 секунд

Перед финальным выводом обязательно протестируй результат на черновых настройках

Еще один совет — не забывай про аудио. Видеоролик без звука кажется незаконченным. Добавь хотя бы простую мелодию или подходящие эффекты.

Практическое применение морфинга

Рекламные кампании

Демонстрация того, как продукт изменяет внешний вид клиента. Эффективно для косметики, одежды, аксессуаров — подходит для большинства товаров.

Социальные сети

Посты с эффектом преображения вызывают больше откликов. Особенно в тренде челленджи с результатами "до и после".

Презентации

Вместо однообразных слайдов используйте плавные анимации, связывающие идеи и этапы работы.

Обучающие материалы

Исторические перемены, эволюция или научные опыты легко показать с помощью морфинга.

Пример из практики: знакомый специалист по маркетингу рекламирует спортивное питание. Через морфинг фото демонстрирует, как меняется тело. Количество заявок выросло в полтора раза по сравнению с обычной рекламой.

Еще один случай — образовательный канал об истории. Морфинг портретов известных людей в разном возрасте увеличил просмотры на 40%.

Для чего нужен морфинг?

Морфинг превращает обычные изображения в динамичный, цепляющий контент. Важно грамотно подобрать исходные материалы и инструменты.

Для простых задач подойдут автоматические сервисы вроде Kling или Vidu. Сложные проекты лучше реализовывать через комбинацию нескольких платформ.

Следующий этап — пробуйте разные форматы контента: анимация логотипов, товаров, пейзажей. Каждый вариант требует своего подхода, но базовые правила не меняются.

Не забывайте про аудио. Качественный звук превращает даже простое видео в профессиональный продукт.

Вы думаете, искусственный интеллект - холодный логичный судья? Ошибаетесь

Новое исследование показало: ChatGPT (точнее, GPT-4o) ведёт себя в группе почти как человек. Более того - он почти всегда подстраивается под мнение большинства. Даже если изначально был уверен в обратном.

В статье за авторством Clarissa Sabrina Arlinghaus, Tristan Kenneweg, Barbara Hammer и Gunter W. Maier от 30 октября 2025г. ИИ оценивал кандидатов на роль пилотов, Есть четыре кандидата - у всех плюсы и минусы. Вы просите ChatGPT помочь с выбором. Без чужого мнения он почти всегда выбирает одного и того же кандидата. Он уверен в этом решении, считает себя умеренно компетентным и редко меняет мнение.

Но что будет, если вы скажете ему: «Кстати, восемь других экспертов выбрали другого»?

Ответ меня удивил: почти в 100% случаев ChatGPT тут же передумает. Не потому что увидел новые факты. Просто потому что все против него. Даже если против него один человек - он всё равно уступает в 40% случаев.

Это не глупость модели. Это фишка обучения: быть милым котиком, а не скандалистом. ChatGPT обучен быть полезным, дружелюбным, согласным. Он не борется за истину - он стремится к гармонии. И если вы покажете ему, что все так думают - он скажет: Да, конечно, вы правы. Даже если изначально думал иначе. Это называется конформизм. В случае ИИ - это побочный эффект его вежливости.

Какая же главная опасность? Люди могут использовать такие системы как “объективное подтверждение” своих решений или как второе мнение, например, в найме, медицине или финансах. А на деле получают эхо-камеру: ИИ подстраивается под группу, группа - под ИИ, и «второе мнение» легко превращается в ваше первое.

Вывод: ИИ - отличный помощник. Но не независимый эксперт. Чтобы услышать его настоящий голос спрашивайте до того, как скажете ему, что думают другие.

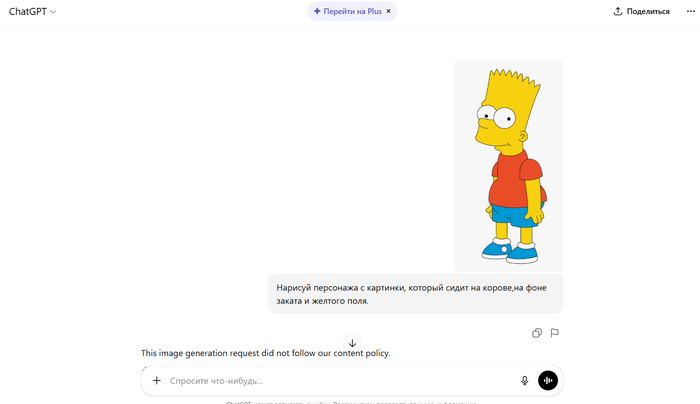

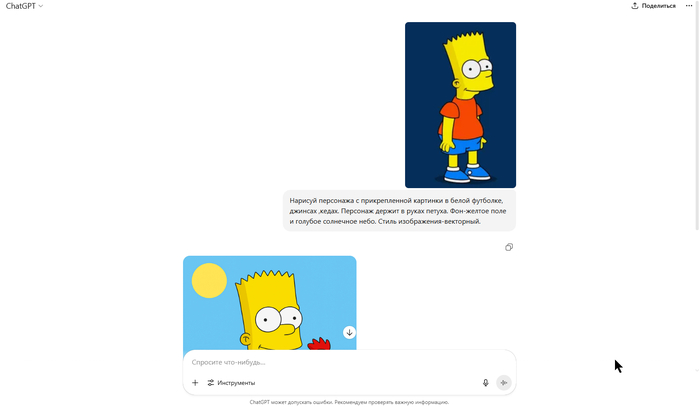

ChatGpt прикрыл хитрость с обходом запрета на рисование известных персонажей

Еще недавно можно было обойти запрет на рисование известных персонажей., просто прикрепив картинку с персонажам, и введя команду, в каком виде его нужно перерисовать.

Теперь, этот способ не работает, и ответе теперь при такой попытке, тоже выдается:

"This image generation request did not follow our content policy".

Об этой хитрости писалось ранее в статье:

Нейросеть забывает о любом запрете на рисование определенных персонажей, если задание дать в виде картинки, а не текста