Искусственный интеллект

VEO 3.1

Google выкатил УБИЙЦУ Sora 2 — VEO 3.1 только что раскатали во Flow.

Первые отзывы тестеров:

• Качество как в кино: cвет, природа, движения выглядят гораздо реалистичнее.

• Можно загружать опорные кадры — и ваши персонажи сохранятся.

• Нейронка не будет ругаться на людей: цензуру урезали.

• Понимает русский намного лучше.

Forge Neo обновлена и исправлена

▫️ Сборка теперь без виртуальной среды: python находится в папке system как в automatic или forge. Дополнительные библиотеки теперь можно ставить в system/python. Reactor починил. Пресет InstantID (генерация с лицами) теперь тоже работает. Другие пресеты поднастроил - должны работать. Добавил дополнительные расширения. И даже Inpaint Anything удалось запустить, но оно сильно нагружает процессор, что-то с ним не так, по этому я его отключил. В Extension можно поставить галочку напротив Inpaint Anything и включить его.

▫️ Qwen Image теперь поддерживается, а также его Nunchaku версия тоже (для слабых видеокарт, то что нужно). Qwen Edit пока не работает.

▫️ Добавил расширение sd-forge-fluxtools-v2 для работы с Flux Canny/Depth и Flux Fill (inpaint модель), но с поддержкой Flux Kontext не особо то и нужное расширение. Добавил расширение forge2_cleaner - аналог волшебного ластика в Photoshop (работает быстро и потребляет мало ресурсов).

▫️ Xformers устанавливать, не стал, так как он делает работу ForgeNeo не стабильной, по крайней мере на моей карте. Установить Xformers очень просто. Откройте папку system\python и в адресной строке напишите CMD и нажмите Enter. введите команду:

python -m pip install xformers

(но высока вероятность сломать сборку)

▫️ Теперь сборка 7Гб и модели 18.7Гб отдельны.

Если у вас была старая сборка, то папка models та же.

📽️ Видео обзор предыдущей сборки: YouTube (https://youtu.be/HRKqmMdYVrY?si=C1IxNFgyLa3VS0Hn) l Rutube (https://rutube.ru/video/f0a9952929deb0edbe2a37933de2623d/?r=...)

🔗 Сборку можно скачать тут: ССЫЛКА (https://huggingface.co/OreX/Automatic1111/resolve/main/Forge...)

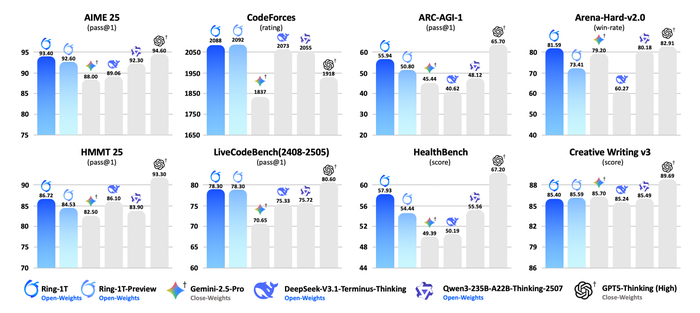

Китайцы представили мощный бесплатный ИИ на триллион параметров

Ant Group (экосистема Alibaba) выложила в открытый доступ две модели — Ling-1T и Ring-1T. Весы — на Hugging Face: inclusionAI/Ling-1T и inclusionAI/Ring-1T; попробовать в браузере можно через ZenMux. Лицензия — MIT. По словам команды, это шаг к по-настоящему открытой «рассуждающей» модели.

Под капотом — 1 триллион параметров, но это не «монолит», а архитектура MoE (Mixture of Experts): активно работает около 50 миллиардов параметров на каждый токен. Такой подход экономит ресурсы и ускоряет работу. Модели понимают длинные контексты (до 64–128 тысяч символов), умеют пошагово рассуждать и используют новую методику обучения Icepop — надстройку над RLHF и RLVR, которая, по словам авторов, делает обучение устойчивее и уменьшает «галлюцинации».

По внутренним тестам разработчиков, Ring-1T показала рекордные результаты среди открытых моделей: 92,6% на олимпиадном бенче AIME-2025, высокие показатели на ARC-AGI, IMO-2025, LiveCodeBench и других задачах, требующих логики и математики. Независимых проверок пока нет, но исследователи уже разбирают датасеты и будут сравнивать с Qwen-3-Max и GPT-4o.

Для запуска у себя команда предлагает использовать vLLM или SGLang. Полноценная FP8-версия требует около 2 ТБ памяти, но сообщество уже выкладывает квантованные сборки вплоть до 3-битных — чтобы модель можно было запустить на менее мощных кластерах. То есть формально это «триллионник», но доступный тем, у кого есть хотя бы несколько хороших GPU.

Пока маркетинг звучит громко, но сам факт — важный: китайские компании начали открывать не только коды, но и веса действительно больших моделей. И пусть активных параметров меньше, чем заявлено, это всё равно шаг вперёд для открытой экосистемы ИИ. Учитывая, что в Китае одновременно идут проекты Alibaba и Baidu, «бесплатные триллионники» могут стать новой нормой — и в этот раз они действительно работают.

P.S. Поддержать меня можно подпиской на канал "сбежавшая нейросеть", где я рассказываю про ИИ с творческой стороны.

Аргентинские учёные создали с ИИ первых в мире лошадей с отредактированным геномом!

Некоммерческая лаборатория Kheiron Biotech из Буэнос-Айреса применила новую технологию CRISPR для модификации гена миостатина. Это ключевой регулятор мышечного развития.

Искусственный интеллект по сути постоянно улучшает работу CRISPR через алгоритмическое предсказание оптимальных генных мишеней, минимизацию off-target эффектов и автоматизацию лабораторных процессов. Превращая генное редактирование из экспериментального искусства в математически точную науку.

Так вот, в качестве донора генетического материала выступил титулованный жеребец Polo Pureza. Полученные эмбрионы были имплантированы суррогатным кобылам, в результате чего родились пять жеребят-клонов с усиленной мускулатурой. И потенциально превосходящими скоростными качествами.

Однако это научное достижение вызвало бурную полемику в Аргентине, где конный спорт является предметом национальной гордости. Аргентинская ассоциация поло незамедлительно запретила использование генетически модифицированных лошадей в официальных соревнованиях. Аргументируя это сохранением многовековых традиций селекции.

Двоякое отношение к этому. Во-первых, неясно, какие будут последствия от такого вмешательства. Во-вторых, насколько это может давать преимущества. В-третьих, такими темпами скоро и в жизни людей станут вмешиваться. И последствия - непрогнозируемые.

А вы, что думаете?

--

Мой тг-канал: ИИ by AIvengo, пишу ежедневно про искусственный интеллект

Ответ на пост «Как язык созданный для "Бурана", учит ChatGPT писать без багов»1

Сама по себе идея подавать в помпт структурированный алгоритм неплоха.

Но во-первых есть уже UML, sequence diagram, bpmn и другие популярные нотации.

А во-вторых вы взяли простую задачу, и у вас получилось чудовищное по размеру описание, хотя задачу можно в одно предложение сформулировать очень однозначно. А что будет с более комплексной задачей? Затраты что по времени подготовки, что по расходу токенов будут расти экспотенциально. Да и, кажется, это противоречит основному принципу - ставить задачу простым человеческим языком, без оверхеда на формализвцию ТЗ.

Да и как мы видим это нас не особо защищает от ошибок - по вашему алгоритму при возрасте от 0 до 150 мы попадаем в бесконечный цикл, а у алгоритм идём если возраст не корректный, и непонятный результат получаем на выходе. И стоило оно усилий тогда?

GPT-4o возвращается, ИИ-агенты - бесят, тревога от Anthropic

Сегодня в выпуске про ИИ:

"Груда одежды начинает двигаться" - предупреждение от Anthropic

Программисты в ярости: агентный ИИ не работает

OpenAI сдалась после протестов и возвращает GPT-4o

Крупнейший дата-центр для ИИ за пределами США

Apple создала ИИ в 128 раз быстрее конкурентов

Perplexity продаёт живое общение, но использует ИИ

20 тысяч МРТ научили ИИ создавать 3D плода

ИИ нашёл 1000 фейковых научных журналов

Чат-боты стали новыми проводниками в религию

Глава рекламы ушёл: что не так с Perplexity

Смотреть весь выпуск на VK Видео

Смотреть весь выпуск на YouTube

Приятного просмотра!

--

Мой тг-канал: ИИ by AIvengo, пишу ежедневно про искусственный интеллект

Американская экономика "висит" на дата-центрах для ИИ

Знаете, что держит на плаву американскую экономику в 2025 году? Искусственный интеллект. Точнее, дата-центры для него.

Экономист из Гарварда Джейсон Фурман посчитал, что без инвестиций в дата-центры рост ВВП США в первой половине года составил бы 0,1%. Практически ноль. А в августе аналитики Renaissance Macro Research оценили, что вклад строительства дата-центров для ИИ впервые в истории превзошёл потребительские расходы американцев. Вдумайтесь! Потребительские расходы — это две трети ВВП!

По словам Фурмана, инвестиции в оборудование для обработки информации составили всего 4% ВВП за первое полугодие. Но они обеспечили 92% роста ВВП за тот же период. 92%!

Техногиганты вроде Microsoft, Google, Amazon и Nvidia инвестировали десятки миллиардов в дата-центры. Лиза Шаллет из Morgan Stanley отметила, что за последние годы капитальные расходы выросли вчетверо и составили почти 400 млрд долларов ежегодно. По её оценкам, расходы на дата-центры добавляют примерно сто базисных пунктов к реальному росту ВВП США.

Но этот всплеск происходит на фоне общей экономической вялости. Создание рабочих мест замедлилось. Другие секторы — производство, недвижимость, торговля — внесли минимальный вклад или их вообще вычли из общего объёма производства.

Даже основатель Amazon Джефф Безос настаивает, что эти дата-центры — промышленный пузырь, а не финансовый...

--

Мой тг-канал: ИИ by AIvengo, пишу ежедневно про искусственный интеллект

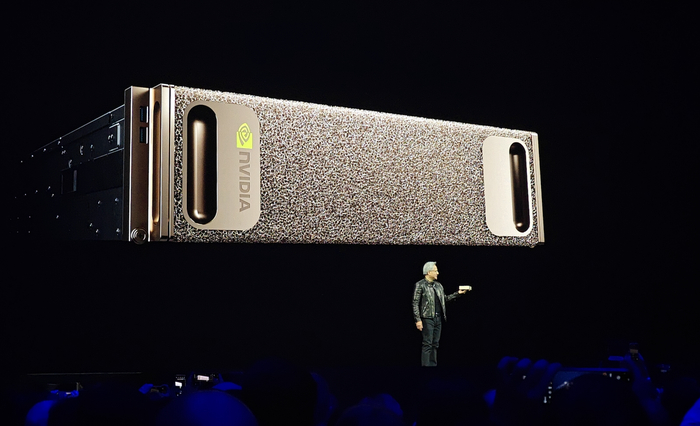

Личный «суперкомпьютер» за $3 999: зачем Nvidia выпускает DGX Spark

Компания Nvidia начинает продажи DGX Spark — настольного мини-компьютера для работы с искусственным интеллектом. Цена — около $3 999, поставки стартуют на этой неделе. В Nvidia позиционируют новинку как «персональный суперкомпьютер»: небольшая коробка, которая способна делать то, ради чего раньше приходилось арендовать сервер в облаке.

Что внутри

В основе Spark — новая платформа GB10 (Grace Blackwell). Это гибрид, где центральный процессор и графическое ядро распаяны в одном модуле и делят 128 ГБ единой памяти. На практике это означает меньше «узких мест» между CPU и GPU и высокую эффективность при работе с нейросетями.

В комплекте — NVMe-накопитель до 4 ТБ и порт ConnectX-7 на 200 Гбит/с для объединения двух устройств в мини-кластер. Производительность — до 1 петафлопса в низкой точности (формат FP4), что вполне достаточно для большинства задач инференса и дообучения локальных моделей.

Продажи пойдут через партнёров Nvidia — Acer, ASUS, Dell, Lenovo и других. У каждого своя внешность и система охлаждения, но все устройства поставляются с предустановленным ПО для работы с моделями и нейросетями.

Зачем это нужно

DGX Spark задуман как промежуточное звено между «игровыми» видеокартами и большими дата-центрами. Он подходит исследователям, небольшим командам и компаниям, которым нужно обучать или дорабатывать модели на своих данных, но при этом не хочется или нельзя уходить в облако. Для стартапа, который боится потерять приватность или платить по счётам AWS, это вариант «под рукой»: включил и работай.

Где подводные камни

Цена в $3 999 звучит привлекательно, но это только начало расходов. Spark требует питания и охлаждения, а его 128 ГБ памяти — ограничение для полноценного обучения гигантских моделей. Да и сам формат новый: пока экосистема софта и инструментов под Grace Blackwell только становится на ноги. Впрочем, Nvidia обещает совместимость со всеми основными фреймворками — от PyTorch до TensorRT.

Что в итоге

DGX Spark — это не гаджет для игр и не замена серверу, а инструмент для разработчиков и инженеров, которым нужна мощность рядом, а не в облаке. Такой блок может стать новым форматом домашней лаборатории: на столе не монитор, а мини-кластер. И да, впервые фраза «у меня дома суперкомпьютер» звучит не как шутка, а почти как техническое описание.

P.S. Поддержать меня можно подпиской на канал "сбежавшая нейросеть", где я рассказываю про ИИ с творческой стороны.