Искусственный интеллект

Видеогенератор Veo 2 от Google. Мой обзор и тест. Как дополнительно попробовать бесплатно

Действительно очень круто работает с физикой - особенно это видно на моем видео с бульдогом, как живой:

Людей не оживляет, даже человекоподобного робота мне на фото не оживил. В общем, если захотите оживлять изображение, убедитесь, что на нем не человек, или не человекообразное существо, а то не пропустит цензура. Мне даже зайца не дал оживить, только вязанную игрушку (на превью), зато качество мне понравилось!

Как сгенерировать такие реалистичные видео

Вообще, более реалистичные по качеству видео получаются из референсов, то есть с предоставлением изображений. И Veo 2 не стал исключением - именно из изображений получились самые качественные видео. Идеально, если они, как мои, сгенерированы в Midjourney, это самая реалистичная нейросеть пока, что бы кто ни говорил, да и по настройкам ушла далеко вперед. Я учу этому в Закрытом клубе Midjourney.

Кстати, кто хочет научиться профессионально генерировать реалистичные изображения, а значит и видео - добро пожаловать ко мне на обучение Midjournrey. Все обновления вы потом бесплатно получаете как член клуба, так как всё быстро устаревает, а на постоянные обучения денег не напасёшься, я это понимаю.

Ну в целом понятно, что из реалистичных изображений почти любой видеогенератор сделает качественное реалистичное видео. А как дела обстоят с генерацией видео по обычной текстовой подсказке? Разбираемся!

Генерация видео в Veo 2 по текстовой подсказке Text-to-Video

Что касается генерации людей по текстовой подсказке: text-to-video с людьми делает, не работает со знаменитостями.

Очень резво и быстро по промпту мне генерировал походку девушки по пляжу:

Видео загружается в mp4, на выбор можно сгенерировать видео длительностью до 8 секунд, настроить вертикальное или горизонтальное разрешение, и сколько на выходе видео сгенерируется.

Как и где можно попробовать Google Veo 2:

Видеогенератор можно использовать в AI Studio (нужен иностранный IP-адрес), бесплатно доступно 5 видео в день. Кому мало, вот вам еще 2 бесплатные генерации в день во Freepik — Заходим в Generate Video — Custom и выбираем модель Google Veo 2.

По сравнению с Sora от OpenAI, Veo 2 отличается более реалистичными текстурами и движениями.

В общем, резюмируя, Google Veo 2 хороший видеогенератор, но лучшие видео создаются из изображений референсов, научитесь создавать красивые и реалистичные изображения в Закрытом клубе Midjourney.

А если вы хотите, чтобы вам простым человеческим языком разжевали, какие есть языковые модели (ChatGPT, Claude и иже с ними), зачем они нужны, как с ними взаимодействовать - вам сюда. И уж тем более, если вы пришли с работы и вам некогда тестировать этот нескончаемый поток нейросетей:

Попишитесь на НейроProfit и узнайте, как можно использовать нейросети для бизнеса, учебы и работы, не теряя свое время.

Нейро-дайджест: ключевые события мира AI за 5 – 12 мая 2025

Привет! 👋

Это новый выпуск «Нейро-дайджеста» — коротких и полезных обзоров ключевых событий в мире искусственного интеллекта.

Меня зовут Вандер и каждую неделю я делаю обзор новостей о нейросетях и ИИ.

Неделя выдалась насыщенной: Google выкатил мощнейшую версию Gemini, Pinterest вернулся в игру с обновлённым AI-поиском, а легендарный Clippy — теперь с нейросетью на борту — снова жив. Всё самое важное — в одном месте. Поехали!

📋 В этом выпуске:

🧠 Модели и LLM

Gemini 2.5 Pro — апдейт кода, видео и интерфейсов

Seed-Coder 8B — кодер от ByteDance с фильтрацией

Mistral Medium 3 — почти Sonnet, но в 7 раз дешевле

🎨 AI-видео

Luma Reframe — outpaint теперь и для видео

Project Odyssey — как сделать AI-фильм и не разориться

🛠 AI-инструменты и интерфейсы

Clippy — возвращение легендарной скрепки с LLM!

Pinterest — обновление визуального поиска

AI Mode от Google — поиск стал интерактивнее

🖥 AI в обществе

Робот-аптекарь в Минске

Routematic — $40 млн на AI для транспорта

API LLM — почему цена за токен обманывает?

🧠 ИИ-модели

❯ Gemini 2.5 Pro — апдейт кода, видео и интерфейсов

Google обновила свою флагманскую модель до версии Gemini 2.5 Pro Preview (05-06) — и это одно из самых мощных улучшений в линейке. Модель теперь показывает выдающиеся результаты в программировании, UI-дизайне и работе с видео.

Что изменилось:

— Кодинг и фронтенд: Gemini заняла первое место в рейтинге WebDev Arena, обогнав даже Claude 3.7 Sonnet. Улучшены генерация UI-компонентов, работа с анимацией и точность редактирования кода. Разработчики отмечают баланс скорости и надёжности — особенно в задачах с высокой нагрузкой.

— Видео: модель набрала 84,8% в бенчмарке VideoMME. Это позволило запускать пайплайны, которые раньше были невозможны — например, создавать обучающие веб-приложения прямо из YouTube-видео.

— Интерфейсы и функции: Gemini научилась лучше разбирать визуальные задачи, упрощать фронтенд-логику, сокращать ошибки в вызовах функций и ускорять отклик на сложные команды.

Важно: цена не изменилась. Обновлённая версия уже доступна в Vertex AI, AI Studio и приложении Gemini. Пользователям ничего не нужно переключать — версия 03-25 теперь ссылается на свежий билд 05-06.

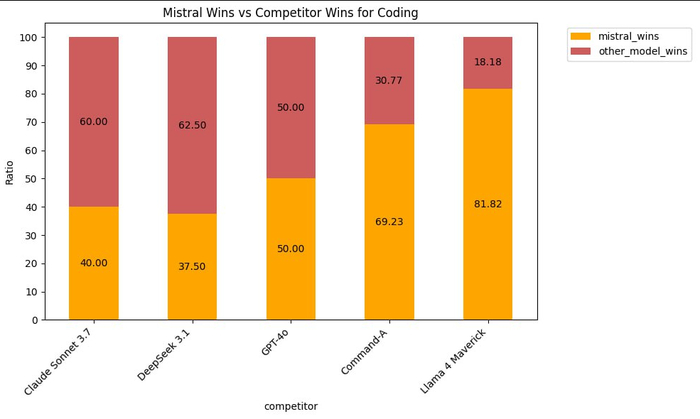

❯ Mistral Medium 3 — почти Sonnet, но в 7 раз дешевле

Французский стартап Mistral представил новую мультимодальную модель Mistral Medium 3, и она уже влетела в топы. По качеству — уровень Sonnet 3.7, по цене — в 7–8 раз дешевле конкурентов.

Главный упор — на задачи программирования и STEM. В этих областях модель обходит LLaMA 4 Maverick и спокойно конкурирует с лидерами. Но самое интересное здесь — цена за миллион токенов: $0,4 на вход и $2 на выход. Это почти беспрецедентно для такого уровня качества.

Mistral Medium 3 пока не open-source, доступ только через API. Но разработчики обещают, что в будущем появится более крупная открытая версия. С учётом тренда на демократизацию моделей — вполне может стать следующим хитом в open-комьюнити.

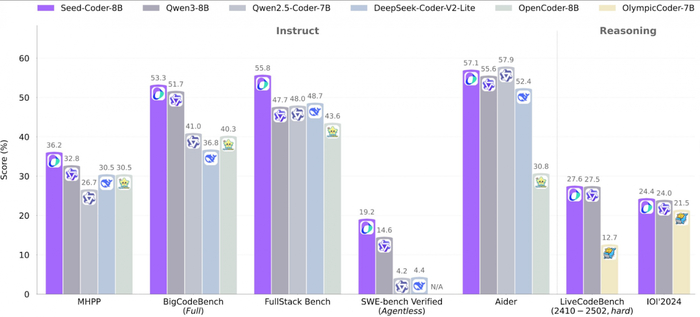

❯ Seed-Coder 8B — кодер от ByteDance с фильтрацией

Владельцы TikTok выпустили Seed-Coder 8B — компактную языковую модель, заточенную исключительно под программирование. Несмотря на размер, она обходит даже свежий Qwen 3 на коде и показывает топовый результат среди моделей своего класса.

В чём сила:

— Жёсткая фильтрация данных: модель обучена на «model-centric» пайплайне. Вместо миллиарда сырых примеров — качественный отбор с помощью других LLM. В итоге в датасете остались только хорошо структурированные, читаемые и модульные фрагменты кода.

— Минимум токенов — максимум выхлопа: тренировку провели всего на 6 трлн токенов, а это в 5 раз меньше, чем у конкурентов. Seed-Coder уверенно обходит аналоги своего размера по генерации, автодополнению и решению задач на reasoning.

— Две версии: Instruct — для обычных задач, Reasoning — для более сложных. Обе выложены в открытый доступ и уже тестируются на Hugging Face.

Это редкий пример, когда маленькая модель не просто «дешевле и быстрее», а реально догоняет (и обгоняет) более крупные аналоги — за счёт чистого датасета и архитектурных решений.

🔗 GitHub проекта 🔗 Reasoning-модель на HF 🔗 Instruct-модель на HF 🔗 Обзор на AIBase 🔗 Обсуждение на Reddit

🎬 AI-видео

❯ Luma Reframe — outpaint теперь и для видео

Компания Luma AI добавила в свою платформу функцию Reframe — это полноценный outpaint, который работает не только с изображениями, но и с видео. Теперь можно загрузить ролик, выбрать формат — и ИИ сам достроит недостающие части кадра, как в генеративной графике. Но с движением.

Reframe даёт возможность свободно перемещать объекты, менять пропорции и кадрировать материал под любые форматы: от Instagram Reels до широкоформатного YouTube. Всё это происходит прямо в браузере и не требует глубоких знаний монтажа.

Фича работает на базе Dream Machine, доступна в подписках Unlimited и Enterprise. Уже сейчас ей активно пользуются креаторы, которые адаптируют свои вертикальные ролики под горизонтальные платформы — и наоборот.

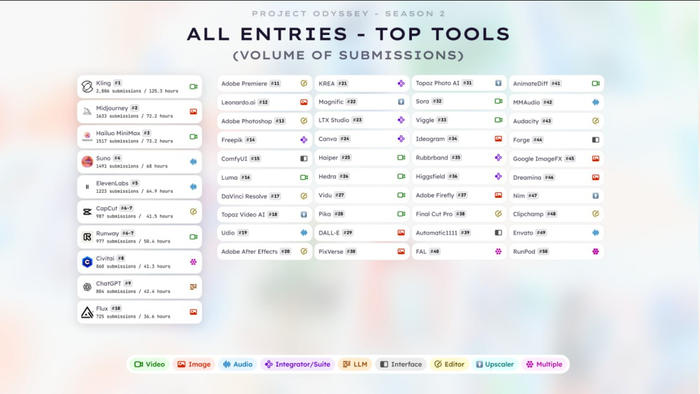

❯ Project Odyssey: сколько стоит минута AI-фильма и почему музыка всё решает

Организаторы крупнейшего конкурса AI-фильмов Project Odyssey: Season 2 опубликовали отчёт по итогам соревнования. 500 финалистов рассказали, какими инструментами пользовались, сколько времени и денег потратили — и что действительно помогает победить.

Средняя стоимость одной минуты AI-видео — $70 на токены и 12 часов работы. Почти все участники тратили 10+ часов на один ролик, и 91% делали это в команде.

Использование ChatGPT для написания сценариев показало низкую эффективность: по «очкам» он проиграл обычным сценаристам. Побеждали те, кто совмещал AI-генерацию с человеческим продакшеном.

Интересный нюанс: ни один финалист с полностью AI-сгенерированной музыкой не получил приз. Весь топ — с живыми саундтреками.

Также Recraft неожиданно обошёл по результативности более популярный Kling — возможно, из-за того, что средний уровень у пользователей последнего был ниже.

Итог: автоматизация — хорошо, но AI всё ещё не заменяет вкус, опыт и монтаж. А вот ускоряет — отлично.

🛠 AI-инструменты и интерфейсы

❯ Clippy — возвращение легендарной скрепки с LLM!

Тот самый 📎Clippy из MS Office 97 вернулся как локальный AI-ассистент, который умеет запускать языковые модели прямо у тебя на компьютере. Проект собрал независимый разработчик Felix Rieseberg, оформив всё в ретро-интерфейсе а-ля Windows 98. Получилось не просто мемно, а реально удобно.

Clippy работает оффлайн, не требует установки и поддерживает собственные модели, промпты и настройки. Внутри — связка llama.cpp и node-llama-cpp, которая автоматически подбирает лучший способ запуска модели: CUDA, Metal, Vulkan и так далее. Поддерживаются Windows, macOS и Linux.

Это не просто рофельная оболочка. Clippy — портативный интерфейс для запуска LLM без облаков, без слежки и без лишней сложности. Своего рода «AI с человеческим лицом и ностальгией».

❯ Pinterest — обновление визуального поиска

Pinterest обновился – завезли визуальный поиск, и теперь он реально помогает найти то, что нравится. Пока фичи работают только в категории женской моды и только в США, Канаде и Великобритании — но первые отзывы уже отличные.

Теперь при нажатии на пин всплывает анимированное свечение, которое подсвечивает ключевые элементы изображения. После этого Pinterest показывает слова, описывающие, что именно в картинке тебя зацепило — цвет, фасон, материал. За этим стоит визуально-языковая модель (VLM), которая анализирует картинку и превращает её в понятный запрос.

Также можно уточнять поиски: находить похожие вещи, смотреть другие стили или цвета — всё это встроено прямо в ленту. Вдобавок Pinterest начал маркировать изображения, созданные нейросетями, и дал возможность ограничить их показ в ленте — по просьбам пользователей.

Задача сервиса — вернуть себе статус главного AI-инструмента для вдохновения и покупок. Пока выглядит как шаг в правильную сторону.

❯ AI Mode от Google — поиск стал интерактивнее

Google расширила доступ к AI Mode — теперь он открыт всем пользователям Labs в США. Вместо классической строки поиска ты получаешь интерактивный диалоговый интерфейс, похожий на ChatGPT или Perplexity, но с данными из всей экосистемы Google.

Новое обновление делает поиск ещё удобнее: появляются визуальные карточки с рейтингами, отзывами, ценами и фото. Например, спрашиваешь про винтажные магазины — получаешь список с рабочими часами и кнопкой «как доехать». А если ищешь товар — видишь реальные цены, акции, наличие на складах и даже доставку.

AI Mode также запоминает, что ты искал, и позволяет быстро вернуться к предыдущим темам. Всё работает в одном окне, без кликов по сайтам. Это уже не поиск в привычном смысле, а полноценный AI-помощник для принятия решений.

Пока только на английском и только в США, но очевидно: это тест перед глобальным запуском.

🏛 ИИ в обществе

❯ Робот-аптекарь в Минске

На вокзале «Минск-Пассажирский» появилась первая в СНГ аптека без фармацевта. Работает она круглосуточно и управляется искусственным интеллектом от российской компании Smart Engines. Покупателю достаточно выбрать препарат на экране, показать паспорт — и робот сам выдаст нужное лекарство.

Внутри установлен стеллаж с 300+ видами безрецептурных препаратов. Робот проверяет возраст по документу, принимает оплату и контролирует температуру внутри капсулы.

Главное — всё работает офлайн, без отправки личных данных. Даже рукописные рецепты и паспорта в неудобных положениях система считывает без ошибок — благодаря нейросетям с архитектурой «Да Винчи».

Разработчики обещают, что в будущем роботы смогут выдавать и рецептурные лекарства, а пока — проходят тестирование в Беларуси. В России такая система уже используется в банках, нотариатах и аэропортах, но в аптеке — впервые.

🔗 CNews

❯ Routematic — $40 млн на AI для транспорта

Индийский стартап Routematic привлёк $40 млн инвестиций в рамках раунда Series C. Деньги пойдут на развитие AI-решений для логистики и корпоративных перевозок, а также на расширение парка электромобилей с ИИ-навигацией.

Главная фишка компании — использование нейросетей для оптимизации маршрутов: учёт пробок, загрузки машин, времени ожидания и даже предпочтений сотрудников.

Система уже работает у крупных заказчиков в Индии, а теперь Routematic выходит на рынки Юго-Восточной Азии и Ближнего Востока.

Фокус — на автоматизации: ИИ планирует смены водителей, строит расписания и помогает сократить расходы на топливо и рабочее время. По сути, это AI-диспетчерская, которая управляет корпоративным транспортом без участия человека.

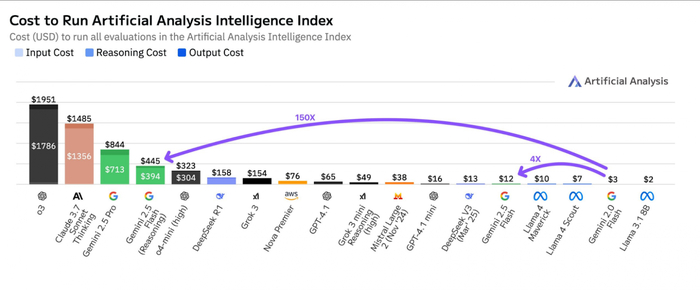

❯ API LLM — почему цена за токен обманывает?

Платишь за токены, но переплачиваешь в разы — ArtificialAnalysis показал, что «цена за миллион токенов» почти ничего не говорит о реальной стоимости задач. Всё решают скрытые факторы: многословность модели, контекст, формат вывода и поведение на промптах.

Например, Gemini 2.5 Flash с reasoning может обойтись в 150 раз дороже, чем та же версия без reasoning — даже если цена за токен почти не отличается. А o4-mini, при том что дороже по токенам, в ряде задач оказывается дешевле на практике, потому что пишет короче и не тратит лишнее.

Особенно это критично при масштабировании — когда ты запускаешь сотни или тысячи запросов. Модели с красивым прайсом вроде $1/млн токенов могут выдавать в 2.5–3 раза больше текста, чем нужно. А это уже реальные деньги.

Вывод: перед внедрением LLM в продукт нужно тестить не прайс, а итоговую стоимость в боевых задачах.

🔮 Заключение

Подытожим. Вот что происходило на неделе с 5 по 12 мая:

— Gemini на максималках: Google докрутил кодинг, видео и интерфейсы — и теперь реально претендует на первое место среди LLM.

— Open-source по-прежнему давит снизу: Seed-Coder и Mistral Medium показывают, что маленькие модели могут бить больших, если правильно фильтровать данные.

— Инструменты всё ближе к пользователю: Clippy — уже не шутка, Pinterest — не просто вдохновение, а полноценный визуальный AI-поиск.

— ИИ лезет в оффлайн: от аптек и транспорта до диспетчеров и ассистентов.

— Деньги решают — но не так, как ты думал: API может стоить копейки за токен и при этом сжирать бюджет на ровном месте.

AI всё глубже проникает в жизнь. Он уже не просто рисует картинки — он управляет логистикой, помогает в аптеке и диктует, как строить поиск. И каждую неделю эта граница смещается всё дальше.

Какая новость поразила тебя больше всего? Пиши в комментах! 👇🏻

Omni reference в Midjourney v7 Разбор новых команд --oref и --ow для работы с референсами

Недавний релиз Midjourney v7 принёс пользователям возможность точечно переносить отдельные элементы, стилистические приёмы или персонажей из уже созданных изображений в новые проекты. Для этого теперь используются две усовершенствованные команды — --oref и --ow. Основная особенность новой технологии omni-reference состоит в том, что можно брать конкретные детали ранее используемого изображения, вместо того чтобы полностью переносить персонажа или его стиль, как делали старые команды --cref и --sref. Теперь художник может самостоятельно выбирать, какие именно элементы будут перенесены, делая процесс создания изображений существенно гибче и удобнее. Более того, новая команда --oref гораздо лучше справляется с передачей человеческих черт лица и точных форм объектов по сравнению с устаревшей — --cref.

В данной статье мы подробно рассмотрим принцип работы функции Omni-reference в Midjourney, выделим ключевые нюансы её использования, а также укажем на типичные ошибки, допускаемые многими пользователями при работе с ней.

На что способна опция --oref в Midjourney?

Функция --oref дает пользователю возможность использовать отдельные элементы исходного изображения в процессе генерации новой картинки. С ее помощью можно:

перенести на новое изображение конкретные детали и объекты из источника;

повторить стиль и художественные особенности исходного изображения;

использовать аналогичную среду и локации;

передать в новое изображение черты лица персонажей с оригинальной картинки;

точечно выбрать, какие именно объекты или детали необходимо перенести (для этого следует тщательно и понятно прописать нужные элементы в текстовом промте).

Также доступен контроль уровня влияния изображения-источника с помощью дополнительной команды --ow, с которой можно настроить степень переноса элементов на новое изображение.

Вы уже наверняка слышали о нашумевшей нейросети Sora Images от OpenAI, которая впечатляюще точно выполняет заданные команды-промты и позволяет брать отдельные фрагменты изображения в качестве образца. Похожую технологию под названием Omni-reference предлагает нам и новая версия Midjourney v.7, однако с одним важным дополнением: теперь пользователи вручную задают степень сходства создаваемой картинки с исходным референсом с помощью параметра —ow.

Параметр —ow принимает значения от 1 до 1000: чем выше указанное число, тем точнее нейросеть воспроизводит детали и стиль изображения-референса. Если цифру не указать, по умолчанию используется оптимальное значение 100, полностью удовлетворяющее запросам большинства пользователей.

Стандартный запрос для команды omni-reference без дополнительных заданных параметров выглядит следующим образом:

подробное изображение лисы, находящейся в лесу, с использованием лица из моего загруженного изображения -oref https://forum.yesai.su/uploads/monthly_2025_05/large.file_27...

Как мы видим, в данном случае изображение лисицы не появилось. Это объясняется тем, что по умолчанию параметр --ow принимает стандартное значение 100, если его не указать явно. Продолжим изучение вопроса.

Если итоговое изображение слишком сильно похоже на исходное, как случилось чуть ранее, стоит снизить значение параметра --ow — это уменьшит степень влияния оригинальной картинки на результат.

подробное изображение лисы, находящейся в лесу, с использованием лица из моего загруженного изображения --oref https://forum.yesai.su/uploads/monthly_2025_05/large.file_27... --ow 50

Как мы можем заметить, лицо на оригинальном изображении приобрело отчётливые черты лисы. Для того, чтобы достигнуть наиболее подходящего и устраивающего вас эффекта, рекомендуем изменить значение параметра --ow. Не стоит пренебрегать данной настройкой, так как именно она часто влияет на итоговый результат и позволяет исправить несовершенства изображения.

При работе с Midjourney и подборе параметров для генерации изображений следует ориентироваться на следующие важные моменты:

1. Параметр "--oref" несовместим с версией "--v 6" в Midjourney. Чтобы избежать ошибок в генерации, обязательно используйте версию "--v 7".

2. Все вспомогательные параметры (например, "--oref", "--ow") нужно строго размещать в конце текста вашего промта, не помещая их в начало или середину.

3. Сразу за параметром "--oref" указывайте прямую ссылку на изображение-референс. При этом поддерживается только одна ссылка — использование нескольких ссылок невозможно.

4. Если вы взаимодействуете с ботом @yes_ai_bot в Telegram, ввод промтов допустим на русском языке. В официальном интерфейсе Midjourney наоборот — сообщения должны быть исключительно на английском.

5. Для получения прямой ссылки на изображение подходят сервисы dropbox.com, disk.yandex.ru, postimages.org. Однако ссылки с подобных ресурсов в Discord иногда работают нестабильно. Гораздо надежнее пользоваться Telegram-ботом @yes_ai_bot, поскольку он стабильно воспринимает ссылки практически с любых популярных облачных хранилищ.

Как сгенерировать изображение, используя функцию omni-reference через Yes Ai Bot?

Есть простой и доступный каждому способ:

Перейдите в чат с ботом, кликнув на ссылку @yes_ai_bot

Введите команду --oref, вставьте после нее ссылку на референс и подробно напишите нейросети, какие именно элементы взять из указанного примера и как использовать их при создании нового изображения.

Как применять omni-reference для создания изображений с помощью Telegram-бота Yes Ai Bot: альтернативный способ

Откройте Telegram-бота по ссылке: @yes_ai_bot

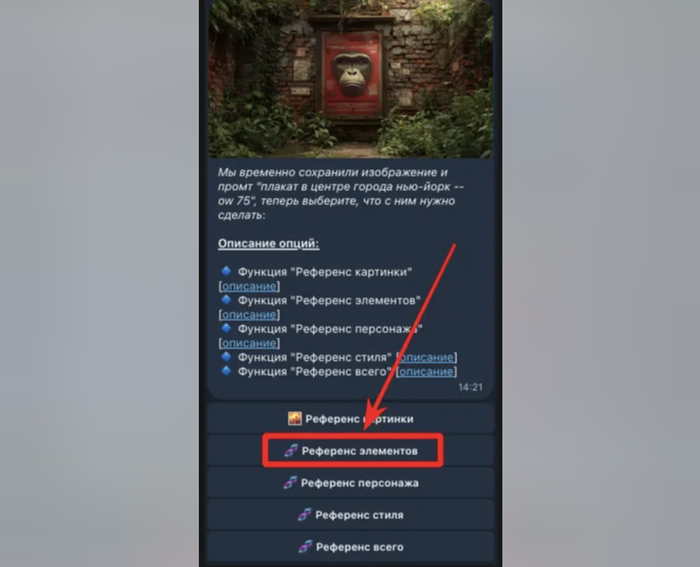

Отправьте боту выбранное вами изображение, которое станет базой для дальнейшей генерации. К изображению приложите поясняющий комментарий (так называемый промт), который четко описывает, какую именно задачу должен выполнить бот. Также при желании добавьте специальный параметр "--ow", значение которого выбирается от 1 до 1000. В тестовом режиме рекомендуется устанавливать значения в интервале от 30 до 200.

После отправки изображения и промта появится меню — здесь необходимо выбрать опцию «🧬 Референс элементов».

Комментарий специалиста

Функция --oref показывает отличные результаты, однако ее эффективность очень сильно зависит от того, насколько грамотно и корректно составлен промт. В этом отношении инструмент заметно уступает аналогичной функции, предлагаемой платформой Sora Images. Также определенные трудности у пользователя вызывает обязательная загрузка исходного изображения на внешнюю платформу перед началом работы. Несмотря на указанные сложности, нельзя не отметить, что по качеству художественного исполнения Midjourney явно выигрывает у схожего решения от OpenAI.

Заключение

Работать с сервисом Sora Images удобнее и проще, особенно для начинающих пользователей, поскольку она четко распознает команды и промты. Тем не менее, по художественному качеству готовых изображений Sora ощутимо отстает от Midjourney. Помимо того, стоимость услуг Sora выше. Значительным плюсом платформы Sora является возможность использовать от одного до десяти референс-изображений. Midjourney, в свою очередь, предоставляет пользователю лишь один исходный референс при генерации.

Функция Omni-reference, предлагаемая Midjourney, требует от человека опыта, навыков и терпения, так как подбор оптимального значения параметра "--ow" нередко занимает до десяти пробных запусков. Однако, несмотря на трудозатраты, результативность Midjourney заметно выше; изображения, полученные через этот сервис, имеют гораздо лучшее художественное исполнение. Основной же недостаток Midjourney заключается в ограничении на использование только одного референса.

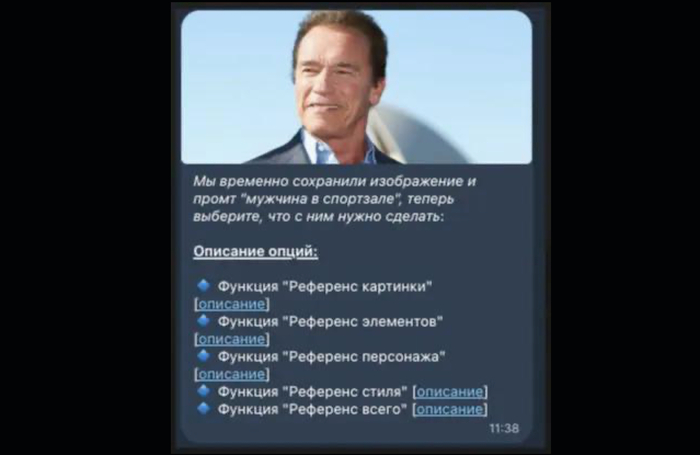

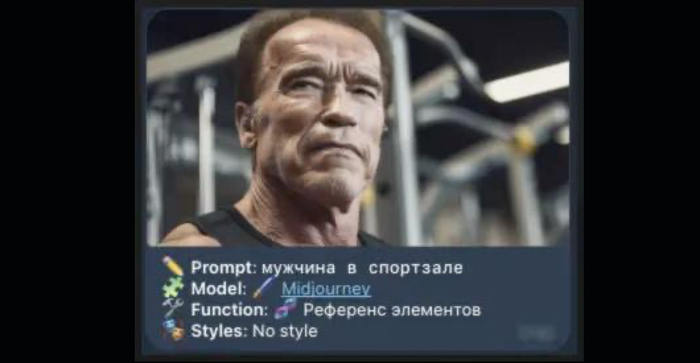

Обратите внимание, как технология Omni-reference способна реалистично и точно перенести человеческое лицо с исходной фотографии.

Результат, как вы сами можете убедиться, получается поразительно точным и естественным👇. В данном примере мы специально задали простой и понятный запрос, чтобы полностью избежать каких-либо неточностей или ошибок.

Если у вас уже есть собственный сервис и вы задумываетесь о внедрении в него возможностей нейросети Midjourney, воспользуйтесь нашим официальным API с интегрированной поддержкой Omni-reference.

Бесплатный сервис для поиска и исследований с проверенными источниками

В случаях, когда необходимо быть уверенным в достоверных источниках, отлично подойдут сервисы, с загруженной базой данных из исследований, научных статей, учебников и лекций. Словом, без всякого “мусора” из интернета.

Один из таких сервисов, китайский Bohrium - это энциклопедия, с которой можно “пообщаться” как с ИИ чат-ботом, спросить вопрос и получить ответы со ссылками на источники. Кстати, очень удобно сразу в свое исследование или дипломную копировать, все куски “подсвечены”.

Там же можно сделать короткую выжимку, ака саммари, из длинных научных статей.

Можно самостоятельно что-то поизучать, есть меню Library с уже загруженными материалами, разбитыми на предметы и темы. Причем, библиотека внушительная - более 26 академических областей и более 1 000 предметных тем, с МИЛЛИАРДАМИ связанных журнальных статей.

Еще можно подписаться на обновления, и вам будут выдаваться точные рекомендации на основе ваших областей исследований и интересов. А так же все, что необходимо и выходит новенького на тему вашей дипломной работы, например) Сюда же входят и подписки на журналы и ключевые слова. То есть, вы всегда будете в курсе одними из первых.

Больше проверенных инструментов, видеоуроки, секреты промптинга в моем Закрытом клубе. Все обновления вы потом бесплатно получаете как член клуба, так как всё быстро устаревает, а на постоянные обучения денег не напасёшься, я это понимаю.

Еще классно, что:

Там есть исследования с данными, этакий Kaggle, но с пояснениями. Причем из областей наук там есть и экономика, и технологии и даже нейросети.

А, так как туда подгружены и курсы, можно вполне поизучать все, что связано с нейросетями, например.

Работает на DeepSeek R1 с функцией рассуждения, так же доступна модель GPT-4o. Мне она больше нравится, так как у DeepSeek качество ответов хуже, чем у ChatGPT.

Подпишитесь на

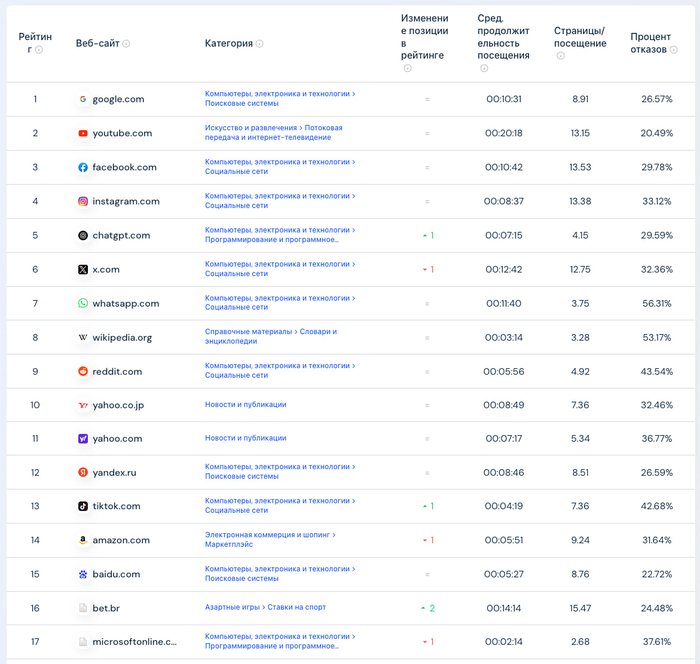

НейроProfit и узнайте, как можно использовать нейросети для бизнеса, учебы и работы, не теряя свое время.Битва нейросетей — как дела с популярностью? ТОП-LLM по посещаемости

1. ChatGPT — 5,1 млрд визитов в месяц. Интересный факт — ChatGPT единственный сайт из топ-10 посещаемых сайтов мира, на котором растет трафик

2. DeepSeek — 480 млн. Открытый код, отличный старт, мощный маркетинг, бесплатно и без VPN для всех стран мира

3. Gemini — 409 млн. Несмотря на мою любовь к Gemini по посещаемости она в 10 раз уступает GPT

4. Grok — 196 млн. Неплохие показатели за счет тесной интеграции с социальной сетью, есть много интересных функций на сайте, отдельный редактор фото, приятная модель, входит в мой личный топ

5. Perplexity — 113 млн. Заточено под поисковые запросы, что-то вроде Google в сфере ИИ (поиск информации), посещаемость падает, так как это по сути агрегатор ИИ-моделей, а не модель. Сам я им не пользуюсь, смысла не вижу, зачем?

6. Claude — 95,6 млн. Любимчик программистов и математиков, если у тебя именно такие задачи, то советую протестировать

7. Copilot — 86 млн. Будет быстро расти, установлена во всех ПК на Windows. Ждем в первой тройке через 1-2 года

8. Qwen — 46 млн. Не заслуженно как по мне, работает лучше DeepSeek, но не хайпанула, советую попробовать

📌 Своими руками покрутить рейтинг можно тут - similarweb (P.S. ссылка на сервис в моем канале в закрепе профиля, тут увы банят за ссылки. Но я буду ОЧЕНЬ благодарен, если вы перейдете и почитаете. Всем позитива и хорошего настроения!)

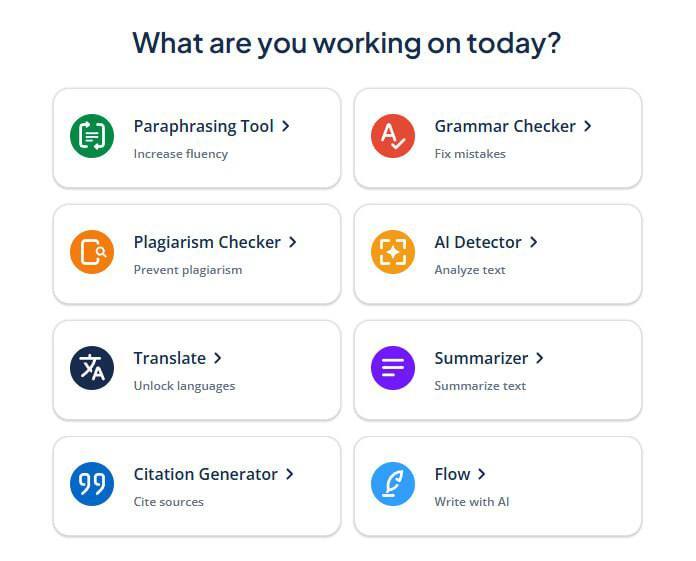

Нейронка для написания курсовых и дипломов

Лучшая нейронка для написания курсовых и дипломов — идеальный помощник для летней сессии.

В QuillBot есть все инструменты:

— Перефразирование текста;

— Проверка грамматики;

— ИИ-детектор и антиплагиат;

— Очеловечиватель текстов;

— Саммарайзер для конспектов;

— ИИ-переводчик документов;

— Генератор цитирования для дипломов и курсачей.

Cравнение цен генерации изображений из разных нейронок

Вывод: если нужно много изображений проще купить 4090 или 5090, сделал сервер и на нём генерить.

Больше интересного: https://t.me/vladimirexp

Как я избавился от рутины с помощью автоматизации без кода: опыт с n8n

Привет! Сегодня хочу поделиться с вами опытом использования невероятного инструмента, который кардинально изменил мой подход к автоматизации. Если вы, как и я, сталкиваетесь с рутинными задачами в работе, будь то создание Telegram-ботов, автоматизация бизнес-процессов или настройка CRM-систем, то, вероятно, вы часто задавались вопросом: как ускорить эти процессы и уменьшить количество ручной работы? Ответ прост — автоматизация. А с помощью инструмента n8n вы можете достичь этого без особых технических навыков. В этой статье я расскажу, как n8n стал моим незаменимым помощником, и почему я больше не трачу время на рутинные задачи.

Что такое n8n и почему это стоит попробовать

Когда я впервые столкнулся с понятием автоматизации, мне казалось, что это исключительно для программистов. Как можно сделать так, чтобы автоматизировать процессы, не зная кода? И вот тут появился n8n, который показал мне, что все гораздо проще, чем кажется.

n8n — это open-source платформа для автоматизации рабочих процессов. Это значит, что вы можете установить её на своем сервере, настроить её так, как вам удобно, и не зависеть от внешних сервисов, таких как Zapier или IFTTT. Почему это важно? Во-первых, n8n не ограничивает вас по функционалу. Во-вторых, у вас есть полный контроль над данными, и, в отличие от облачных сервисов, вы не передаете свои данные третьим сторонам.

Но самое главное, что делает n8n уникальным, это его доступность. Несмотря на то, что за его плечами — мощные алгоритмы и функциональные возможности, работать с ним можно даже без знаний программирования. Все, что вам нужно, — это интуитивно понятный визуальный интерфейс, где процессы строятся как логическая цепочка блоков. Вы не пишете код, а просто соединяете элементы, как пазлы.

Автоматизация без программирования: просто и эффективно

Вы, наверное, думаете: "Автоматизация без кода? Это возможно?" И я вам скажу: да, это реально! С помощью n8n вы сможете автоматизировать процессы, не зная JavaScript или Python. На самом деле, интерфейс напоминает знакомую многим конструкцию Lego: блоки соединяются, а из этого получается нечто целое и полезное.

Рассмотрим на примере, как это работает. Допустим, у вас есть форма на сайте, через которую пользователи могут отправлять заявки. С помощью n8n вы можете настроить процесс, при котором каждая новая заявка автоматически попадает в вашу CRM-систему, отправляется уведомление в Telegram и даже генерируется напоминание в Google Календаре. Все эти действия — без одного написанного кода.

И это лишь один из множества примеров. С помощью n8n вы можете интегрировать практически любой сервис: от почтовых систем до баз данных и социальных сетей. Нужно что-то сложнее? Не вопрос — добавьте JavaScript и сложные условия, чтобы ваши процессы стали ещё умнее.

Почему n8n лучше других инструментов?

В интернете можно найти массу инструментов для автоматизации, таких как Zapier или Make (Integromat). Все они удобны, но есть один большой минус — ограничения. Записываетесь на бесплатный тариф — и вот уже лимит на количество операций достигнут. Требуется сложная настройка — и вы сталкиваетесь с необходимостью использовать лишь те блоки, которые предлагает сервис.

В отличие от них, n8n — это платформа с максимальной гибкостью. Она не ограничивает вас в использовании возможностей. Если вам нужно что-то уникальное, например, интеграция с кастомной API, вы можете настроить всё под себя. Не нужно быть программистом, чтобы реализовать такие задачи. Всё делается через визуальный интерфейс.

Но если вам нужно больше, вы всегда можете добавить сложные скрипты или использовать переменные, условия и циклы для создания более сложной логики.

Как настроить первый процесс в n8n за 15 минут

Самое классное в n8n — это скорость, с которой можно начать автоматизацию. За 15 минут вы сможете настроить свой первый рабочий процесс. Например, давайте настроим автоматический процесс получения заявок с Typeform. Вот что для этого нужно сделать:

Создайте новый workflow (рабочий процесс).

Добавьте блок "Typeform" и подключите его через API-токен.

Настройте логику: если заявка содержит слово "Срочно", отправляем уведомление в Telegram.

Соедините блоки, протестируйте и активируйте процесс.

Все, теперь ваши заявки автоматически обрабатываются, а вы можете расслабиться. Просто представьте, сколько времени вы сэкономите, когда такие рутинные задачи перестанут отнимать ваше время.

n8n для тех, кто хочет большего

n8n — это не только для новичков, но и для тех, кто хочет больше контроля и гибкости. Если вы знаете, что такое сервер и готовы к настройке на своем VPS, это откроет перед вами еще больше возможностей. С помощью серверной версии n8n вы получаете полную свободу: никаких ограничений по операциям, никаких подписок, и полный контроль над данными. Всё хранится у вас на сервере, и только у вас.

Кроме того, этот путь позволяет значительно сэкономить. VPS можно взять за 300–500 рублей в месяц — этого достаточно для большинства задач.

Заключение: ваш путь к автоматизации начинается сегодня

Если вы ещё не пробовали n8n, самое время начать. Берите одну задачу, которая отнимает у вас много времени, и переведите её в автоматический процесс. А дальше — не останавливайтесь. Возможности n8n действительно безграничны, и со временем вы начнете искать всё больше задач, которые можно автоматизировать.

И не забывайте, что если вам нужна помощь в настройке, на моём Telegram-канале я делюсь полезными гайдами, примерами и готовыми шаблонами.